들어가며

2022년 말 ChatGPT가 쏘아 올린 생성형 AI의 등장은 많은 기업에 새로운 사업 기회와 상상력을 가져다주었다. 다양한 분야에서 생성형 AI 기술을 사용하여, 고객 경험의 혁신을 이뤄내려는 다양한 시도가 생겨났다. 기업의 규모와 관계없이 상용 모델의 API를 활용하거나, Llama 등의 오픈소스 모델을 활용해 직접 제품을 개발하는 적극적인 방식으로 새로운 서비스를 출시하고 있다. 이에 덧붙여 아크서치(Arc Search), 퍼플렉시티(Perplexity), 라이너(Liner) 등 새로운 형태의 인터페이스 경험을 지향하는 서비스 또한 나타났다.

하지만 대다수의 AI 기업에서 매출과 비용의 균형을 맞추지 못해 재정적인 어려움을 겪고 있다.[1] 뚜렷한 비즈니스 성과를 내지 못하고 있는 상황에서 생성형 AI 기술은 많은 비용이 요구된다. 대표적인 사례로 스태빌리티 AI(Stability AI)는 이미지 생성 서비스를 제공하며 약 연 9,600만 달러의 비용을 지출하고 있지만, 올해 매출은 겨우 약 6,000만 달러에 머물 것으로 예상한다. 이러한 재정 불균형 문제는 구조조정으로 쉽게 이어진다. 또한 개인 AI 비서 챗봇을 출시한 인플렉션 AI(Inflection AI)나 프레젠테이션을 자동으로 생성해 주는 톰(Tome) AI[2]와 같은 스타트업이 수익은 미미한 상황에서 막대한 AI 비용이 발생하게 되면서 생성형 AI 비즈니스의 지속 가능성에 의구심을 제기하는 목소리가 커지고 있다. AI 산업은 서버 구축·운영과 데이터 확보 및 고급 기술 인력 확보 등에 막대한 투자 비용이 들어가기 때문에 국내에서도 구체적인 사업 성과를 달성하기 전에 경영상의 어려움을 겪는 스타트업을 어렵지 않게 찾아볼 수 있다.[3]

이처럼 구체적인 매출 예상이 확실하지 않은 상황에서 사전에 비용 예산을 심각하게 고려하지 않아 기업 운영에 실패하는 사례가 발생하고 있다. 생성형 AI는 도입 방법 및 사용자, 인터랙션 규모 등에 따라 예상치를 넘는 비용이 발생한다. 따라서 비용(Cost)은 AI 비즈니스의 지속가능성을 평가할 때, 초기부터 가장 먼저 우선적으로 고려해야 할 요소이다. 초기부터 가시적인 수치를 통해 AI 모델의 성능과 비용을 동시에 관리할 필요가 있으며, 사업의 성장 속도에 맞춰 비용을 예측할 수 있어야 한다. 또한 비용 가드레일을 구축하는 등의 노력을 통해 무분별한 지출을 통제하는 것이 필요하다. 이 글에서는 지속 가능한 AI 비즈니스를 영위하기 위해 비용을 산출하고 관리하는 방법에 대해서 다뤄보고자 한다.

목표 및 비용을 고려한 AI 서비스 채택하기

다양한 AI 서비스 구축 방법 중 무엇이 가장 비즈니스에 적합한지 이해하는 과정이 가장 먼저 요구된다. 상용 AI를 통한 서비스 구축은 크게 세 가지 방식으로 나눌 수 있다.

첫째는 타사 공급 폐쇄형 서비스(Third-Party Vendor’s Closed Source Services)이다. 요즘 가장 인기 있는 OpenAI의 ChatGPT나 네이버의 하이퍼클로바X처럼 AI 기업에 의해 제공되는 턴키형 인공지능 솔루션이다. 보장된 성능 모델을 패키지 형태의 관리형 서비스로 제공하기 때문에 빠르게 도입 가능하고 수준 높은 고객 지원 시스템을 주요 특징으로 볼 수 있다. 단, 오픈되지 않은 소스의 형태로 AI 서비스를 사용하는 것이기 때문에 비즈니스 특성에 맞는 커스터마이즈가 어려우며 해당 소프트웨어에 락인(lock-in)되면 벤더 기술에 대한 의존도가 높아질 수 있다.

둘째는 타사 호스팅 오픈 소스 서비스(Third-Party Hosted Open Source Services)이다. 이것은 오픈 소스를 활용하여 비즈니스에 맞게 사용하지만 해당 모델 호스팅 서비스를 써드파티 기업에서 제공하는 것이다. 예시로는 HuggingGPT, Lambda, 국내 기업 카카오의 KoGPT가 있다. 폐쇄형 소스와 다르게 모델의 구조와 학습 방법이 공개되어 있기 때문에 유연한 커스터마이즈 및 개발이 가능하지만 AI 모델의 품질은 이 오픈 소스와 활용도에 따라 변동이 심할 수 있다.

세 번째는 AI 모델을 직접 구축하고 배포하는 DIY 형태를 선호하는 조직의 경우이다. AWS Sagemaker, GCP Vertex, and Azure AI와 같은 하이퍼스케일러를 통해 자체 구축 방식에 필요한 인프라와 도구를 활용한다. 이 방식을 택하면 완전한 모델 통제권을 가질 수 있지만 품질, 정확성, 성능, 개발기간 모두 기업의 역량에 달려있다. 모델을 자체 개발하고 호스팅(Self-Hosted Workloads)하는 방법도 있으나 LLM을 제로베이스로 구축하는 것은 비용이 매우 많이 들기 때문에 LLM 모델을 활용한 서비스의 방법으로서는 제외하였다.

<표 1> AI 서비스 종류별 장단점 비교

| AI 서비스 | 장점 | 단점 |

|---|---|---|

| 타사 공급 폐쇄형 서비스 (Third-Party Vendor’s Closed Source Services) |

신속한 구현 고품질 모델 지속적이고 신뢰성 높은 고객 지원 보안 강점: 벤더는 자사의 모델이 데이터 유출이나 무단 접근을 허용하지 않도록 보장 (벤더의 보안이 미흡할 시 데이터 보호 법령에 따라 심각한 평판 훼손이나 벌금 위험이 있음) |

커스터마이즈 범위가 좁음 벤더 락인 편향성/개인정보 위험 독점 기술로 인한 고비용 AI 기술 업데이트에 대한 벤더 의존도가 높음 |

| 타사 호스팅 오픈 소스 서비스 (Third-Party Hosted Open-Source Services) |

유연한 커스터마이즈 /제어 가능 개인정보 보호/보안 규정 준수 커뮤니티 지원 폐쇄형 서비스보다 경제적인 가격 |

품질, 정확성, 성능: 사용자가 직접 관리/개선 높은 수준의 기술 전문 지식 요구 결과물을 얻는 데 많은 시간 소요 효율적이지 못한 지원 채널 |

| 직접 구축/배포 (DIY on Cloud Provider) |

모델에 대한 완전한 통제권 개인정보 보호/보안 규정 준수 가능 예산 조정 및 관리 가능 다른 클라우드 서비스와의 통합 용이 |

품질, 정확성, 성능: 사용자 책임 AI와 클라우드 관리에서 상당한 전문 지식 필요 시장 진입까지 많은 시간이 소요 |

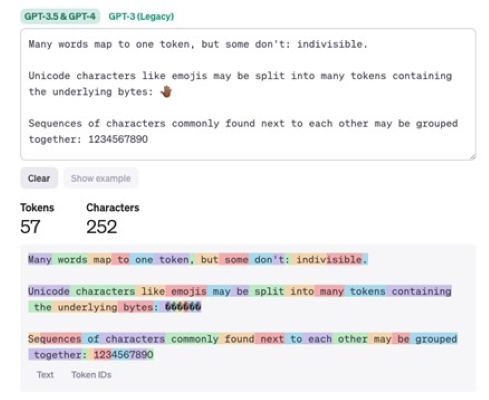

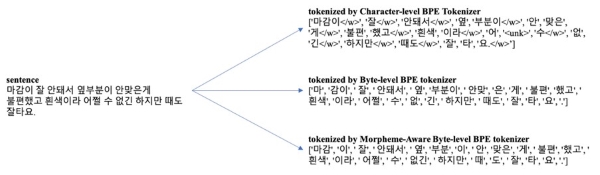

기업 상황에 맞게 위의 세 가지 방법의 비용 요인을 비교하면, 첫 번째 폐쇄형 서비스는 주로 모델 서비스에서 입/출력에서 처리된 단어 또는 기호 수, API 호출 수에 따라 토큰을 계산하여 데이터양만큼 지불하는 방식으로 비용이 책정된다. 언어에 따라 토큰 계산 방법이 다르며 사용하는 만큼 비용을 지불하는 구조라 사용량이 많아질수록 비용은 증가하나 기술 인력이 많지 않은 기업에 장기적으로 더 경제적일 수 있고 배포 능력이 부족한 기업에게 적합한 배포 모델이다. 또한 보안 및 규정 요구 사항을 감사하는 것이 중요하기 때문에 금융 및 의료 분야와 같은 분야에서는 폐쇄형에서 제공되는 보안 프로토콜과 인증이 효율적일 수 있다.[4] 두 번째의 타사 호스팅 오픈 소스 서비스형은 폐쇄형 소스 서비스에 비해 상당히 저렴하다. 그러나 어떻게 비즈니스에 맞게 튜닝해서 사용 및 관리하는지에 따라 비용이 달라질 수 있다. 넓은 확장성이 특징이기 때문에 전문 지식을 갖춘 인력이 필요하다. 전문 인력의 인건비를 고려하면 특정 기업의 경우에는 이 방식이 더 많은 예산이 필요할 수 있다. 세 번째, 기업이 자사의 인프라에 직접 호스팅하는 DIY 방식은 AI 모델을 실행하는 데 필요한 컴퓨팅 리소스, 특히 GPU에 대한 비용을 지불한다. LLM 자체에 대한 라이선스 수수료 지급이 필요할 수도 있고 타 방식보다 더 많은 시간과 전문 인력[5]이 요구된다.

[그림 1] GPT 토큰 운영 방식 (출처: OpenAI)

[그림 1] GPT 토큰 운영 방식 (출처: OpenAI)

[그림 2] 언어에 따른 토큰 계산법 예시 (출처: OpenAI, 네이버)

[그림 2] 언어에 따른 토큰 계산법 예시 (출처: OpenAI, 네이버)

상용 AI를 어떻게 적용하고 활용할 것인지는 AI 모델 선택과 비용 예측에 필수적인 고려 사항이다. 요구하는 성능 중 음성인식이 가능해야 하는지, 이미지 처리가 필요한지, 텍스트 요약, 데이터 분석 등이 필요한지 어떤 영역까지 AI 모델이 필요한지 알아야 하며 복잡도의 경우에도 웹사이트 챗봇처럼 간단한지, 정교함과 인텔리전스 레벨은 어느 정도여야 하는지도 예산 측정에 반영되어야 한다.

여기에 덧붙여 모델 개발에 있어 어떤 방식을 선택할 것인지도 매우 중요하다. 총비용을 계산하기 위해선 ‘서비스 사용량 * 사용요금 = 비용’이란 간단한 예측 방식으로 접근할 수 있다. 사용량과 사용요금은 결국 SaaS-AI, PaaS, IaaS와 같은 사용 서비스의 종류, 모델 크기, 적용 태스크에 따른 사용 모델 종류, 토큰별 비용, 서비스 사용 시간에 따른 비용 등 요금 책정 방식에 따라 공식이 조금씩 달라질 것이다.

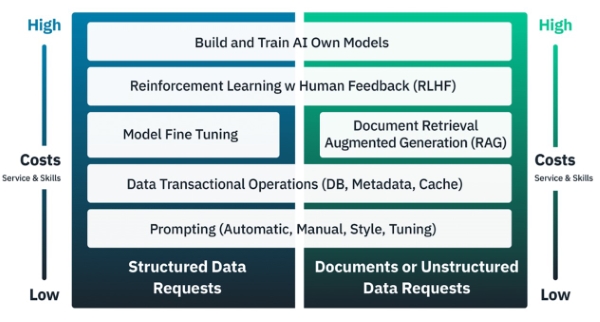

이 공식에 영향을 미치는 LLM 학습 및 개발 방식 중 하나에는 모델의 프롬프트 튜닝이 있다. 이는 수동, 자동, 가드레일 방식으로 유연하게 최적화할 수 있고 이 방식에 따라 다른 수량과 비율이 측정될 수 있다. 프롬프트에 제공된 예시는 정적 또는 동적 프롬프트 입력에 대한 예를 제공하는지에 대한 여부에 따라 제로 샷(Zero Shot) 및 퓨 샷(Few Shot)을 포함한다. 모델 학습 시 아무것도 정보를 제공하지 않을지 정보를 제공하면서 학습할 것인지도 결정할 수 있는데, 이 정보 제공에도 비용이 따른다. 검색 증강생성(RAG: Retrieval-Augmented Generation)은 사실을 검색하여 프롬프트 입력에 포함되고, 사실 대응을 위한 일련의 단계를 제공한다. 파인 튜닝은 POC, 개발 단계, 제품 운영 단계에 따른 모델 품질, 편향, 반복, 환각(할루시네이션)을 처리하는 방법을 다룬다. 인간 피드백을 통한 강화 학습(RLHF)은 특정 출력에 대한 보상 기능을 수정하고, 시간이 경과함에 따라 인간 참여 규모를 조정한다. 스크래치 모델 훈련은 훈련 및 반복을 통해 자체 모델을 생성하고, 재사용 또는 개선과 새로운 훈련 비용 및 품질/정확도와의 교환을 고려한다. 이와 같은 AI 성능을 개선하기 위한 여러 방식은 학습 과정 중 발생하는 변환, 인풋과 아웃풋 등 모든 방면에서 비용이 발생한다고 볼 수 있는데, 어느 정도의 성능이 필요하고, 그 성능을 위해 어떤 학습 방식이 필요한지를 결정해야 한다. 학습 방식을 결정했다면 학습에 비용 요인들이 무엇이 있고 얼마큼 사용되고 이에 따른 비용이 얼마인지 인지해야 종합적이고 정확한 지출 비용을 예측할 수 있다. 복잡하고 번거로울 수 있는 일이긴 하지만 모든 항목이 비용과 직접적으로 연계되어 있다.

[그림 3] AI 모델 개발 단계와 비용 (출처: FinOps Foundation[6])

[그림 3] AI 모델 개발 단계와 비용 (출처: FinOps Foundation[6])

LLM AI 서비스 비용에 영향을 미치는 주요 요인

AI 솔루션 구축 방식을 선택했다면 효과적인 예산 관리를 위해 배포 솔루션마다 비용에 영향을 미치는 요인과 소유권 및 지식재산권의 범위를 이해해야 한다.

첫째, 타사 공급 폐쇄형 AI 서비스는 애플리케이션 API 사용이 주요 원가 요소이다. 사용량은 "토큰 인/아웃"으로 결정되며, 이는 텍스트 단어로 측정된다. 플러그인이나 다른 모델 사용 시 추가 비용이 발생할 수 있다. 시중의 많은 LLM 모델이 영어를 기반으로 하므로 한국어를 입력할 때 더 많은 토큰이 필요할 수 있다. 따라서 도입하고자 하는 상용 AI 모델이 어떤 데이터를 주로 보유하고 있는지, 해당 언어를 어떻게 토큰화하는지 확인하는 것이 중요하다. 기본적으로 이미 완성된 모델에 프롬프트 튜닝 정도만 하기 때문에 모델 학습 비용이 상당히 적게 들지만 고수준의 파인튜닝을 시도하는 경우 비용이 상당히 높은 편이다. 인건비 측면에서는 기술적 전문 지식은 다른 시스템에 비해 덜 필요하며, 대부분의 경우 PaaS 수준의 SKU(Software Key User) 관리 정도가 필요하다.

둘째, 타사 호스팅 오픈소스 모델은 인프라 GPU/RAM 사용량 혹은 대여 시간이 주요 비용 요소이다. 모델 학습과 데이터 처리량 및 저장량에 따라 비용이 발생하지만 어느 정도 학습이 완료된 모델을 이어서 학습시킬 수 있기 때문에 세 가지 방안 중 비용소모는 중간 정도로 볼 수 있다. 그러나 최적의 성능을 내기까지 에는 개발 비용과 개발 인력이 많이 요구될 수 있고, 모델, 데이터 및 API 호출과 같은 다양한 요소에 대한 추가 SKU 비용이 발생할 수 있다. 이에 따라 예산 초과의 위험이 있을 수 있으며, 컴퓨팅 리소스를 관리해야 하고 커스터마이즈를 위해서는 폐쇄형 서비스보다 더 많은 전문 인력과 기술이 필요하다.

셋째, 클라우드 시스템에서의 DIY 방식도 인프라 GPU/RAM 사용량 혹은 대여 시간이 주요 비용 동인이다. 이 방식을 사용하려면 높은 수준의 다양한 기술적 전문 지식이 필요하며, 하드웨어, 소프트웨어, 모델링, 모델 학습, API 및 라이선스와 같은 모든 요소에 대한 SKU를 관리해야 한다. 모델 개발 비용에 대한 자유도는 가장 높으나 처음부터 모델을 학습해야 해서 모델 성능과 사용 방안에 따라 개발비용이 천차만별일 것이다. 그러나 이러한 방식을 선택하면 AI 시스템의 모든 측면에 대한 완전한 통제권을 가지며, 데이터와 지식재산권에 대한 완전한 소유권 및 제어권을 확보할 수 있다. 이러한 비용 동인을 식별하고 이해함으로써 프로젝트 범위, 기술 요구 사항 및 예산에 맞춰 더 많은 정보를 바탕으로 결정을 내려야 한다.

LLM 모델 사용의 방향에 맞춰 AI로 인해 발생하는 비용을 절감하려는 전략이 필요하다. 이 전략을 세우기 위해서는 AI 시스템 배포 전략을 계획하고 기존 지출 약정과 용량에 미치는 영향을 고려해야 한다. FinOps에 따르면 타사 공급 폐쇄형 AI 서비스를 사용할 경우, 수요와 운영 비용이 증가할수록 가격 체제 또한 변동되어 인상될 수 있다.[6] 최신 버전의 LLM/플러그인의 비용은 이전 버전 및 컨텍스트 길이보다 5-20배 더 비싸기에 워크로드에 따라 현명한 결정이 필요하다. 용량 약정 할인은 시간, 금액 및 기간에 따라 다양하며, 기존의 가격 협정에 따라 다르기에 심도 있게 살펴볼 필요가 있다. 타사 호스팅 오픈소스 모델은 훈련/미세 조정 및 POC를 위한 훈련 비용이 빠르게, 많이 줄어들고 있다. 또한 작거나 중간 규모의 배포에서는 하드웨어 가격이 안정화되고 있지만 대규모 배포에서는 GPU 자원이 여전히 제한되어 용량 보장이 필요하며 이전 세대와 동일한 GB RAM/코어 단위 비율을 고려할 때 최신 CPU/GPU/TPU 세대는 단위 요금이 더 높다. 클라우드 시스템에서의 DIY 방식에서 서버리스 및 GPU 관리형 미들웨어 서비스를 통해 비용을 줄이고 필요한 기술과 노력을 감소시킨다. 미리 구축된 모델 템플릿, 발표된 컴퓨터 최적화 권장 사항을 통해 기본 비용과 불필요한 낭비를 줄여 총비용을 낮출 수 있다.

배포 방법에서 고려해야 할 부분도 있다. 가장 비싼 주요 벤더와 완전히 최적화된 플랫폼 선택 사이의 비용 차이는 최대 30배에서 200배까지 다를 수 있다. 특히 기업에서는 이러한 큰 비용 차이에 심도 있는 고민이 필요하다. 입력 프롬프트 최적화와 같은 기술은 입력을 간결하게 하여 비용을 15~25%까지 절감할 수 있다. 또한 기술, 플랫폼, 구성, 확장 및 구매 방법을 함께 최적화하는 것이 단일 전략만 사용하는 것보다 더욱 큰 비용 절감을 가져오는 것으로 확인됐다. 자동화가 더욱 발전함에 따라, 파인 튜닝, 합성 데이터 생성 및 RAG 기능과 관련된 비용 소비도 절감할 수 있는 부분이다.

AI 서비스 운영 시 비용을 적절히 예측하고 통제하기

AI 기반 제품과 서비스의 다양한 기술 계층과 요소들 또한 비용에 영향을 미친다. 일반적으로 ChatGPT나 Claude와 같은 상용 AI 모델의 API를 사용할 경우에는 전체 API 요청 수를 기준으로 비용이 산출된다. 반면 클라우드 시스템을 활용하여 자체적으로 오픈소스 모델 기반의 AI 서비스를 배포할 때는 GPU, RAM, 제공 단위에 따른 저장소나 데이터 처리 비용 등을 모두 고려하여 비용을 계산해야 한다. 엔지니어링팀은 배포 옵션에 따라서 다양한 엔지니어링 레이어에서 발생하는 비용, 성능을 평가하여 효율적인 구축 및 리소스 할당 전략을 세우는 것이 필요하다.

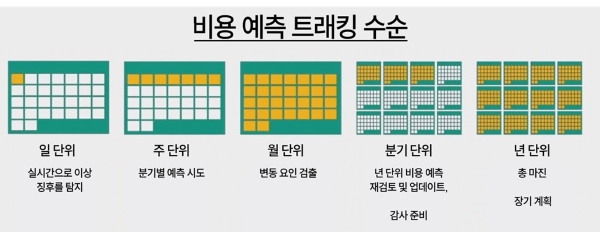

AI 비용 예측을 보다 정확하게 수행하기 위해서는 전사적으로 여러 비즈니스팀이 사용하고 있는 AI 모델의 트래픽 용량 등을 기반으로, 장기적으로 계획을 세워보는 것이 좋다. AI 비용에 대한 예측은 추정치이며, 주기적으로 실제 지출을 모니터링하며 조정해야 한다. 기술적인 변화와 AI 벤더의 가격 정책을 지속적으로 확인하는 것도 비용을 좀 더 정확하게 예측하는 데에 도움이 된다.

[그림 4] 비용 예측을 위한 주기적 모니터링과 계획

[그림 4] 비용 예측을 위한 주기적 모니터링과 계획

AI 시스템 운영의 효율성을 높이고 비용을 효과적으로 관리하기 위해서는 가드레일을 세우는 것 또한 중요하다. 가드레일은 조직의 비전과 제품의 목표를 일치시키고, 위험을 완화하는 데에 도움을 준다. 예산 범위, 기술 사양, AI 벤더 사와 관계, 보안 및 규정 준수, 운영 지표 등을 고려하여 AI 서비스에 대한 가드레일을 세우면, 보다 비용을 잘 예측하고 제어할 수 있는 환경을 만들 수 있다. 아래의 표가 AI 비용을 효과적으로 통제할 수 가드레일로서 참고가 될 수 있다.

<표 2> 비용 가드레일을 위한 범위와 작업 항목 예시

| 범위 | 작업 항목 |

|---|---|

| 예산 |

POC의 경우, 사용 금액 또는 API 작업 수량을 고정 설정한 임곗값에 근접하거나 초과하는 경우, 실시간 알림 예측 비용과 실제 비용, 수량 등을 담은 리포트 배포 |

| 기술 |

적합한 배포 모델 선택 및 사용량 제어 사전 승인 및 엄격한 권한 설정 AI 워크로드 규모를 신중하게 조정 (GPU는 매우 비쌀 수 있음) |

| 벤더 관계 |

벤더 업체와 의존도/종속 가능성 미래 전략에 대한 충분한 신뢰 |

| 보안 및 규정준수 |

역할 간 데이터 공유 위반 사항과 권한 관리 회사의 민감 데이터 보호를 위한 AI 제공자 교육 실행 |

| 테스트, 운영 |

설정 임곗값 대비 사용량과 비용 모니터링 편견, 안전과 같은 윤리적 이슈와 관련된 처리 파이프라인 구축 정확도, 지연 시간, 속도 등에 대한 성능 지표 비용 관리 및 최적화 정책 강화 |

최종적으로 AI 서비스의 성공을 정의하고, 이를 가장 잘 달성하기 위한 방법은 비용 예측을 객관적인 지표로 만들고 그것을 조절하면서 달성하는 노력이 필요하다. AI 모델의 처리 속도, 정확도, 응답 품질 등으로 AI 서비스를 판단하며, 작업 단위당 비용, GPU 비용 등을 효과적으로 관리하여 성능과 비용의 균형을 맞출 수 있다. 이를 위해서 속도 및 정확도 개선, 학습 비용, 토큰 당 비용을 절감하는 등의 엔지니어링 목표 등이 제시된다. AI 서비스에 영향을 주는 여러 요소에 대해서 적절한 엔지니어링 목표의 설정이 필요하고 이를 달성하려는 구성원들의 노력이 필요하다.

마무리

AI 기술은 매일 새로운 업데이트가 추가되며 모든 산업의 잠재력을 높여가지만, 동시에 경기가 악화하면서 AI 기업은 사업 초기부터 지속가능성에 대한 증명을 요구받는다. 아직 성숙하지 않은 AI 분야에서 자생할 수 있는 생존 가능성을 증명해야만 추가적인 투자금을 기대할 수 있는 상황이다. 이것은 많은 스타트업들이 비즈니스 성과를 낙관적으로 예측하거나, 비용을 과소평가하는 등의 지금까지 업무 관행과 연결이 되어 있다고 할 수 있다.

사업 초기에 AI 프로덕트를 만들고 운영에 필요한 전략과 비용 등을 선제적으로 고려하는 것이 리스크를 줄이고, 생존 가능성을 높이는 데 중요하다. 실질적인 성장을 이끌어내지 못한 기업은 시장에서 퇴출되겠지만, AI 시장에 대한 투자는 앞으로 더욱 확대될 것이다. 경쟁적인 시장 상황과 기술 의존성에 구애받지 않고, 견고한 비즈니스 모델을 구축하기 위해서는 기술 민첩성은 유지하되, 비용을 적절히 통제하고 변화에 선제적으로 대응하는 것이 필요하다.

References

[1] 삼성SDS 인사이트 리포트, “2023 국내 AI 도입 및 활용 현황 조사”, Dec 08, 2023.

[2] Deloitte, “TrustID Generative AI Analysis”, August 2023.

[3] McKinsey, “Why AI-enabled customer service is key to scaling telco personalization”, Oct 24, 2023.

[4] Businesswire, “86 Percent of Consumers Will Leave a Brand They Trusted After Only Two Poor Customer Experiences”, Feb 02, 2022.

[5] 헬로T, 통신 산업 AI 활용 규모, 2032년까지 10배 증가 예상, Feb.12, 2024.

[6] McKinsey, “How AI is helping revolutionize telco service operations”, Feb 25, 2022.

[7] The Economist, “Why fintech won't kill banks”, Jul 17, 2015.

[8] Deloitte Insights, “인공지능(AI) 시대, 진화하는 은행업”, Aug, 2023.

[9] Tech42, “‘인터넷은행’이 대세? 가장 많이 사용하는 은행 앱 1위 카뱅, 2위 토스”, Nov 07, 2022.

[10] 이코노미스트, “삼성전자만큼 해외서 돈 버는 핀테크 나왔으면”, Oct 04, 2023.

[11] ZDnet Korea, “신한은행, 배달 앱 '땡겨요'로 소상공인 생태계 만든다”, Oct 19, 2023.

[12] Voicebot, “Bank of America’s AI Assistant Erica Passes 1.5 Billion Interactions”, Oct 19, 2023.

[13] 한국경제, “핀테크는 MZ세대만 쓴다고?…시니어 이용자도 '대표 고객”, Jun 14, 2022.

▶ 해당 콘텐츠는 저작권법에 의하여 보호받는 저작물로 기고자에게 저작권이 있습니다.

▶ 해당 콘텐츠는 사전 동의 없이 2차 가공 및 영리적인 이용을 금하고 있습니다.

![]()

SAP France의 Senior Program Manager

한국에서 컴퓨터 공학을 전공 후, 7년간 한국후지쯔에서 개발자로 근무하고, 1998년 프랑스 파리로 이주하여 Business Objects에서 개발 매니저와 프로그램 매니저를 거쳐, 현재 SAP의 클라우드 ERP 엔지니어링 그룹의 시니어 프로덕트/프로그램 매니저로 근무 중입니다. 책 <프로덕트 매니지먼트>의 저자입니다.