상편에서 우리는 AI 위험이 어떤 경우에 발생하는지 예시를 들어서 살펴보고, 발생 가능한 위험의 인식과 평가는 잘 정리된 프레임워크를 활용하는 경우 효과적으로 식별하고 위험의 경감 방안을 수립하는 데도 도움을 준다는 것을 알 수 있었습니다.

AI 위험 평가 프레임워크의 주요 사례

이제 앞서 소개한 AI 위험 평가 프레임워크를 발표기관의 유형별로 대표적인 사례를 들어 좀 더 구체적으로 살펴보겠습니다. 아래의 AIA(Algorithmic Impact Assessment), AI Safety Index, Secure AI Framework는 각각 정부, 연구기관, 기업의 사례입니다.

(정부) 캐나다 AIA(Algorithmic Impact Assessment)

캐나다는 국가 AI 전략을 수립하여 범 연방 차원으로 확산하고 있으며 AI의 안전성에도 많은 투자를 하고 있습니다.[1] 연방정부는 AI 시스템으로 유발되는 잠재적 위험을 측정할 수 있는 툴을 발표했는데, 이것을 ‘AIA(Algorithmic Impact Assessment) tool’이라고 명명하였습니다.[2] 정부·공공단체 또는 민간 이용자는 연방정부가 공개한 AIA를 자유롭게 활용할 수 있으며, AI 시스템의 기획 단계부터 예상되는 위험 요소와 경감 방안을 입력하여 그 결과가 최종 점수로 산출됨으로써 해당 AI 시스템의 위험 수준을 예측할 수 있습니다.

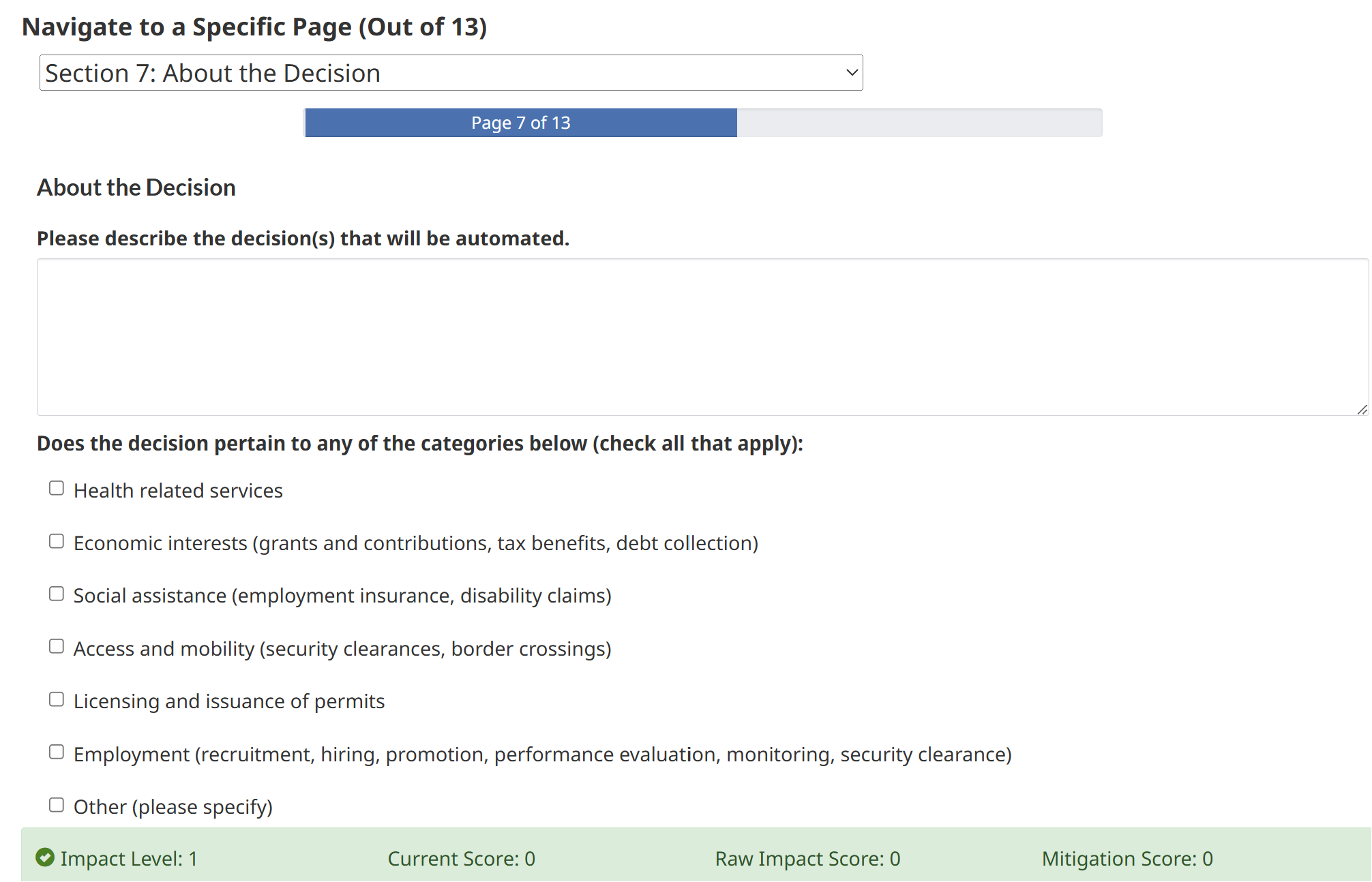

[그림 1] AIA tool 예시 화면[3]

[그림 1] AIA tool 예시 화면[3]

[그림 1]은 연방정부에서 제공하는 시뮬레이션 화면의 총 13개 평가 섹션 중 7번째 ‘의사결정’에 관한 섹션을 보여줍니다. 그림의 상단에서 AI 시스템으로 자동화되는 의사결정이 무엇인지 텍스트로 입력하고, 하단에서는 그 의사결정이 미치는 영향이 어느 영역에 관한 것인지 복수로 체크할 수 있습니다. AIA는 이와 같은 형태로 총 51개의 위험 요소에 관한 점검 항목과 이에 상응하는 34개의 경감 방안을 입력하여 각각을 +, -로 합/감산한 뒤 평가점수를 산출하는 구조입니다. 평가 영역은 크게 프로젝트, 시스템 설계, 알고리즘, 의사결정 유형, 영향 및 데이터 등 5개 영역으로 나누어집니다. AIA의 활용은 AI 시스템의 기획 단계부터 위험의 원인과 그 피해의 양상에 대해 구조적으로 파악하여 그것을 개발 및 그 이후 단계의 관리 방안에 반영합니다. 이는 인지하지 못한 위험의 발생을 최소화하고, 예상되는 위험에 대한 적합한 대응책을 사전에 마련할 수 있다는 장점이 있습니다. AIA는 정부 차원에서 AI의 위험을 예방하고자 공공과 민간에 참고할 수 있는 가이드를 제공한 선도적인 사례입니다. 하지만 정부의 가이드라인은 보편성과 범용성을 확보하다 보니 개별 기업이 도입하는 AI 시스템 및 서비스의 특성과 이로 발생하는 특정 위험을 충분히 도출해 내는 데는 한계점을 가지기도 합니다. 그럼에도 불구하고, AIA가 AI 시스템 제공자로 하여금 AI의 부정적 영향을 인식하고 위험 평가를 활성화하는 데 기여한다는 점은 부정할 수 없습니다.

(연구기관) FLI AI Safety Index

미국의 비영리 단체 중 OpenAI의 GPT-4를 능가하는 AI 시스템 개발에 대해 6개월간 중단을 주장한 것으로 잘 알려진 기관이 있습니다. 바로 삶의 미래 연구소(FLI: Future of Life Institute)인데요. 2024년 12월에 AI 안전성 지표 2024(AI Safety Index 2024)를 발표했습니다. FLI AI Safety Index는 6개의 평가 도메인으로 구성되어 있는데, 각 도메인에 할당된 총 42개의 측정지표에 대해서 범용 AI 모델을 개발하는 기업의 AI 위험 관리 능력을 평가합니다. 각 지표는 최근의 정책이나 학계의 연구에도 부합하면서, 증거에 기반해 상호 비교할 수 있는 항목으로 구성되어 있습니다(<표 1> 참고).

<표 1> FLI AI Safety Index 상세지표[4]

| 리스크 평가 | 현재 해악 | 안전 프레임워크 | 실존적 안전 전략 | 거버넌스 및 책임성 | 투명성 및 커뮤니케이션 |

|---|---|---|---|---|---|

|

|

|

|

|

|

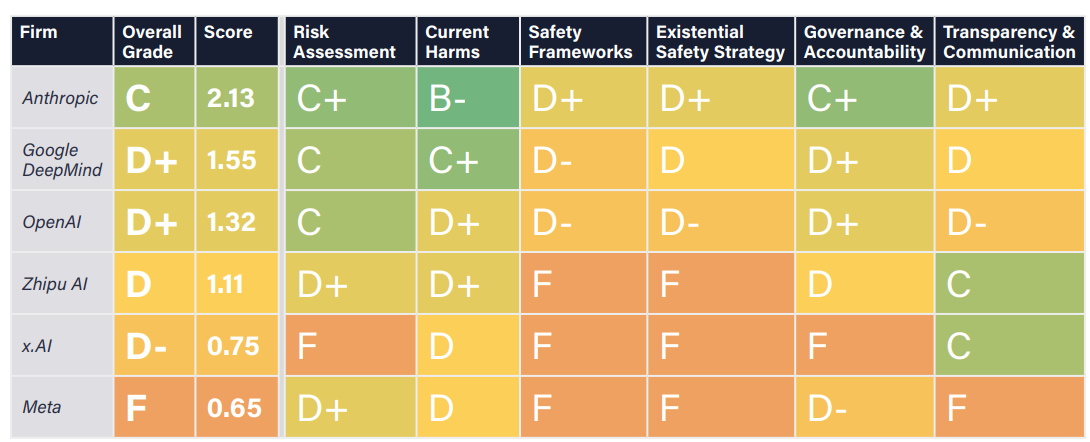

FLI는 7명의 저명한 AI 전문가를 소집하여 AI Safety Index로 대표적인 AI 기업 6개를 평가하도록 하고, 그 결과를 통합하여 도메인별로 A, B, C, D, F의 5개 등급을 산출하였습니다. 'A' 등급은 기업이 안전조치 또는 예방적 접근 방식을 가지고 있는 경우에 해당하고, 'D' 또는 'F' 등급은 기업이 일부 위험만을 완화하거나 위험 완화 효과가 미진한 경우입니다.

[그림 2] FLI AI Safety Index 측정 사례[4]

[그림 2] FLI AI Safety Index 측정 사례[4]

| Firm | Overall Grade | Score | Risk Assessment | Current Harms | Safety Frameworks | Existential Safety strategy | Governance & Accountability | Transparency & Communication |

|---|---|---|---|---|---|---|---|---|

| Anthropic | Google DeepMind | OpenAI | Zhipu AI | x.AI | Meta | |||

| C | D+ | D+ | D | D- | F | |||

| 2.13 | 1.55 | 1.32 | 1.11 | 0.75 | 0.65 | |||

| C+ | C | C | D+ | F | D+ | |||

| B- | C+ | D+ | D+ | D | D | |||

| D+ | D- | D- | F | F | F | |||

| D+ | D | D- | F | F | F | |||

| C+ | D+ | D+ | D | F | D- | |||

| D+ | D | D- | C | C | F |

[그림 2]의 결과를 들여다보면 일부 기업들은 AI 모델 개발 초기에 안전 프레임워크를 구축하고 위험 평가를 실시하는 경우도 있었고, 다른 일부 기업들은 기본적인 위험 경감 조치조차 취하지 않았습니다. AI 전문가들은 6개 기업 모두가 ‘리스크 평가’와 ‘안전 프레임워크’ 준수에 대해서는 제3자의 검증이 필요하다는 의견을 제시하였습니다.[4] 앞서 소개해 드린 AIA가 개별 AI 시스템의 기획 단계에서 진행하는 위험 평가라면, AI Safety Index는 기업이 전사적으로 고려해야 할 전략, 조직 및 리더십, 커뮤니케이션 체계까지 고려하여 평가할 수 있다는 점에서 차이를 가집니다. 그러나, AI 시스템의 기획이나 개발을 담당하는 실무자에게는 활용되기 어렵다는 제약이 있습니다.

(기업) Google Secure AI Framework(SAIF) Assessment

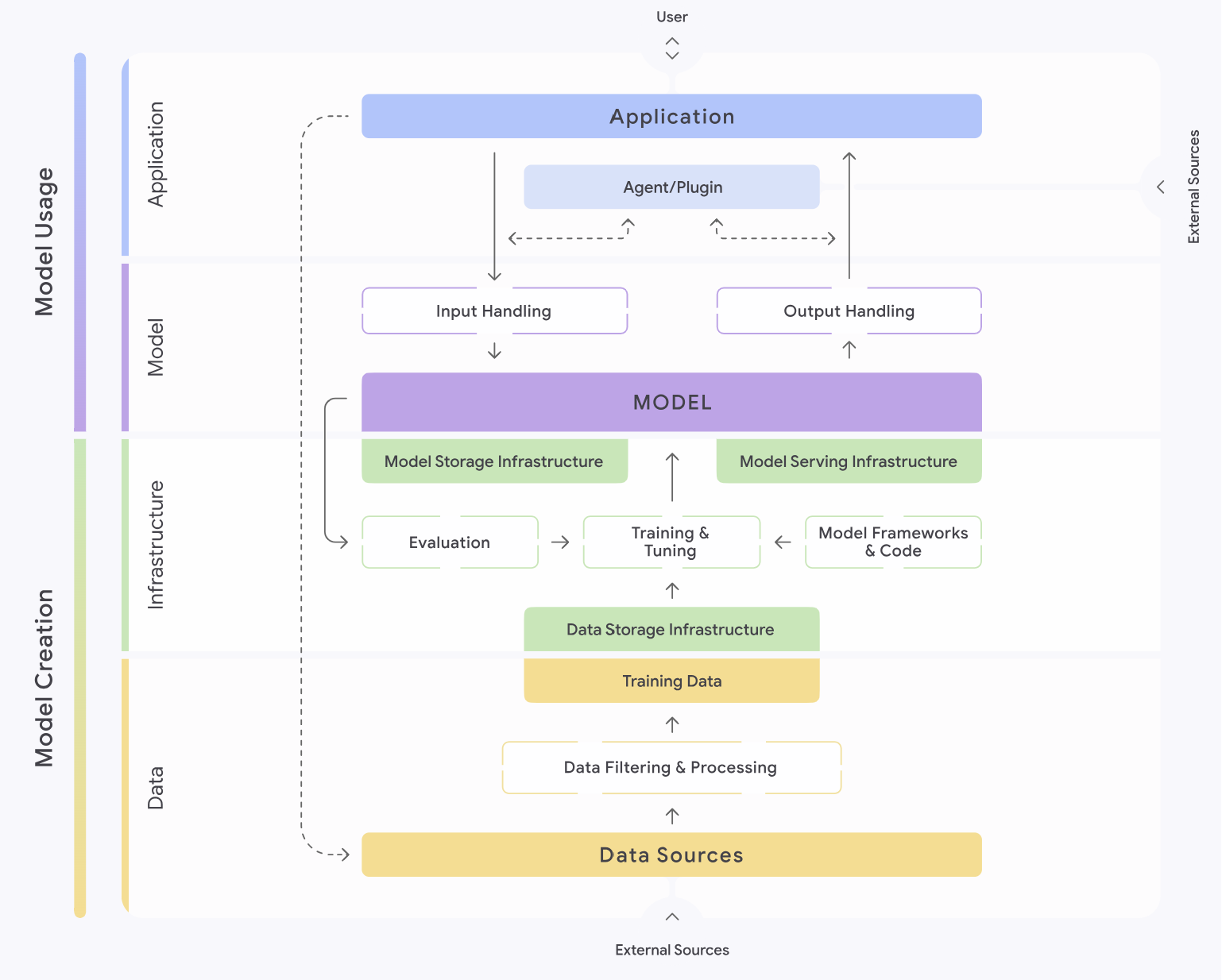

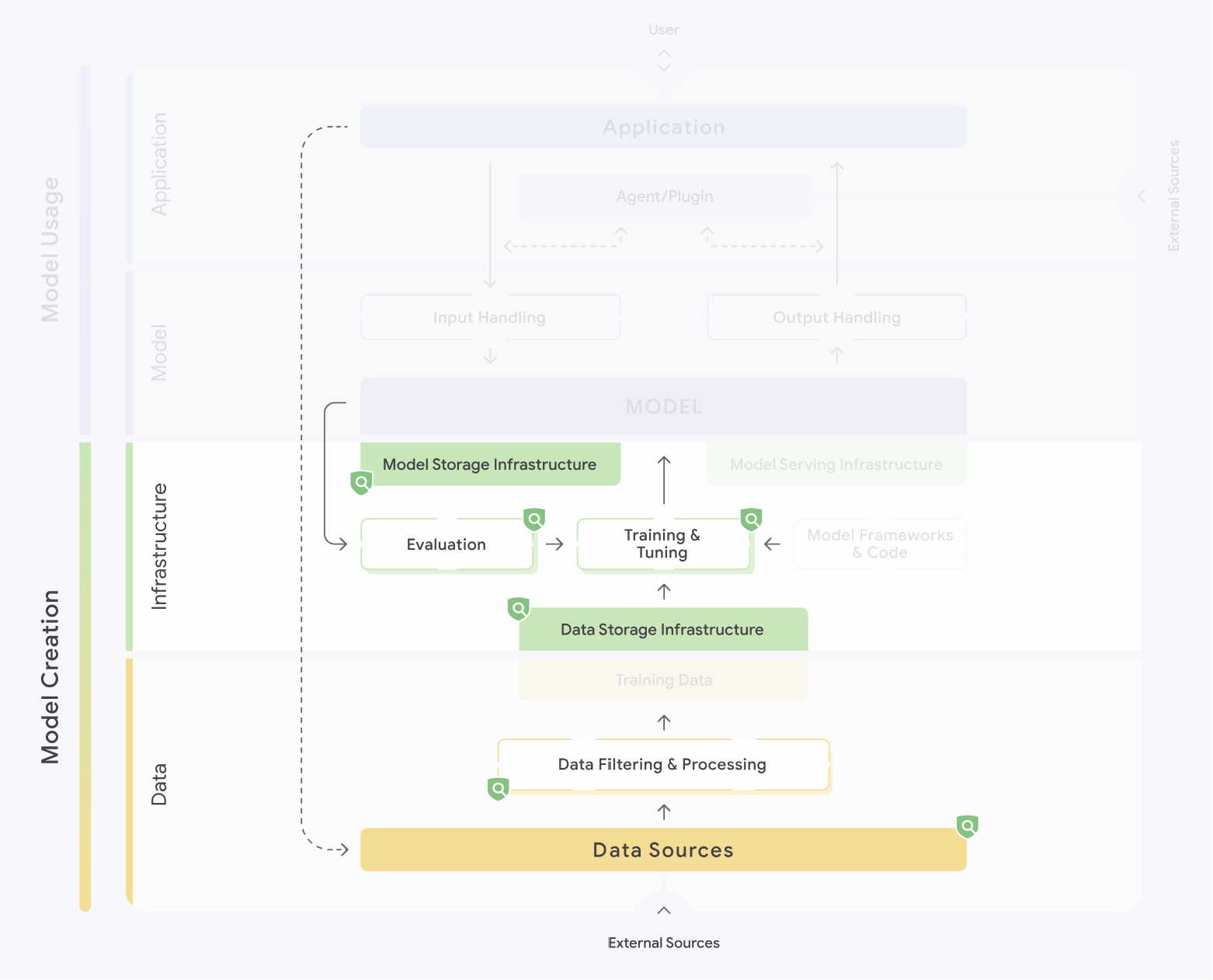

Google은 자사의 미션에 부합하는 AI 원칙을 2018년도에 발표하고, 이러한 원칙을 준수할 수 있는 다양한 실천 방안과 기법을 대내외에 공개하고 있습니다. 2023년에는 ‘Secure AI Framework(SAIF)’를 발표하였는데 이 프레임워크는 비단 보안 위험뿐 아니라 AI 시스템 개발 시 데이터, 인프라, 모델, 애플리케이션 전반에서 노출될 수 있는 위험을 사전에 정의하고 조회할 수 있도록 [그림 3]과같이 SAIF 맵을 제공합니다.[5]

[그림 3] SAIF Map[5]

[그림 3] SAIF Map[5]

Model Usage

User(Outside) ←→ Application-

Application

Application ←→ Agent/Plugin → Input Handling

Application ← Agent/Plugin ← Output Handling

-

Model

Input Handling → MODEL

Output Handling ← MODEL

Model Creation

-

Infrastructure

MODEL + Model Storage Infrastructure

MODEL + Model Serving Infrastructure

MODEL → Evaluation → Training & Tuning ← Model Frameworks & code

Data Storage Infrastructure → Training & Tuning → MODEL

-

Data

Data Storage Infrastructure + Training Data

Data Sources → Data Filtering & Processing → Training Data

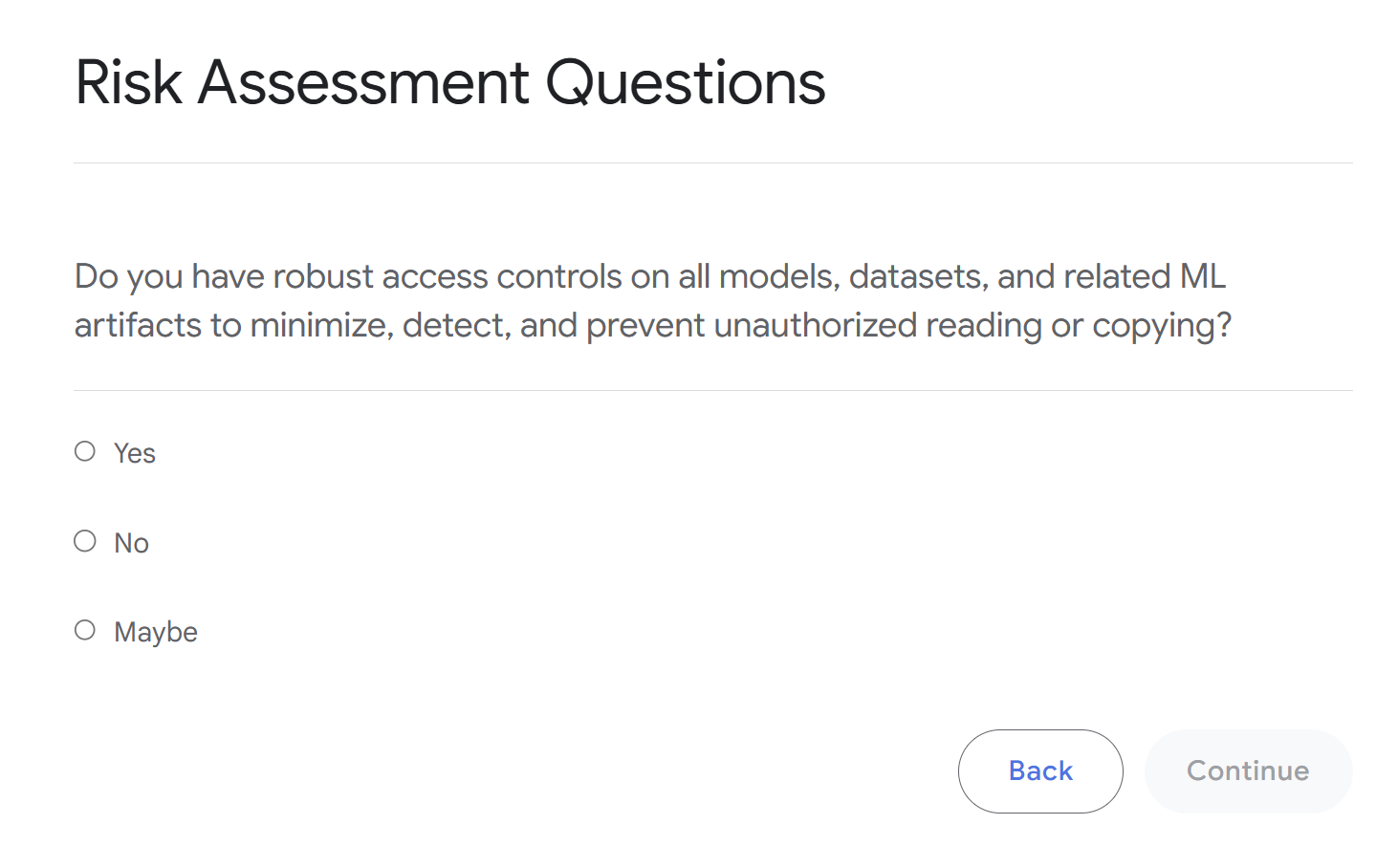

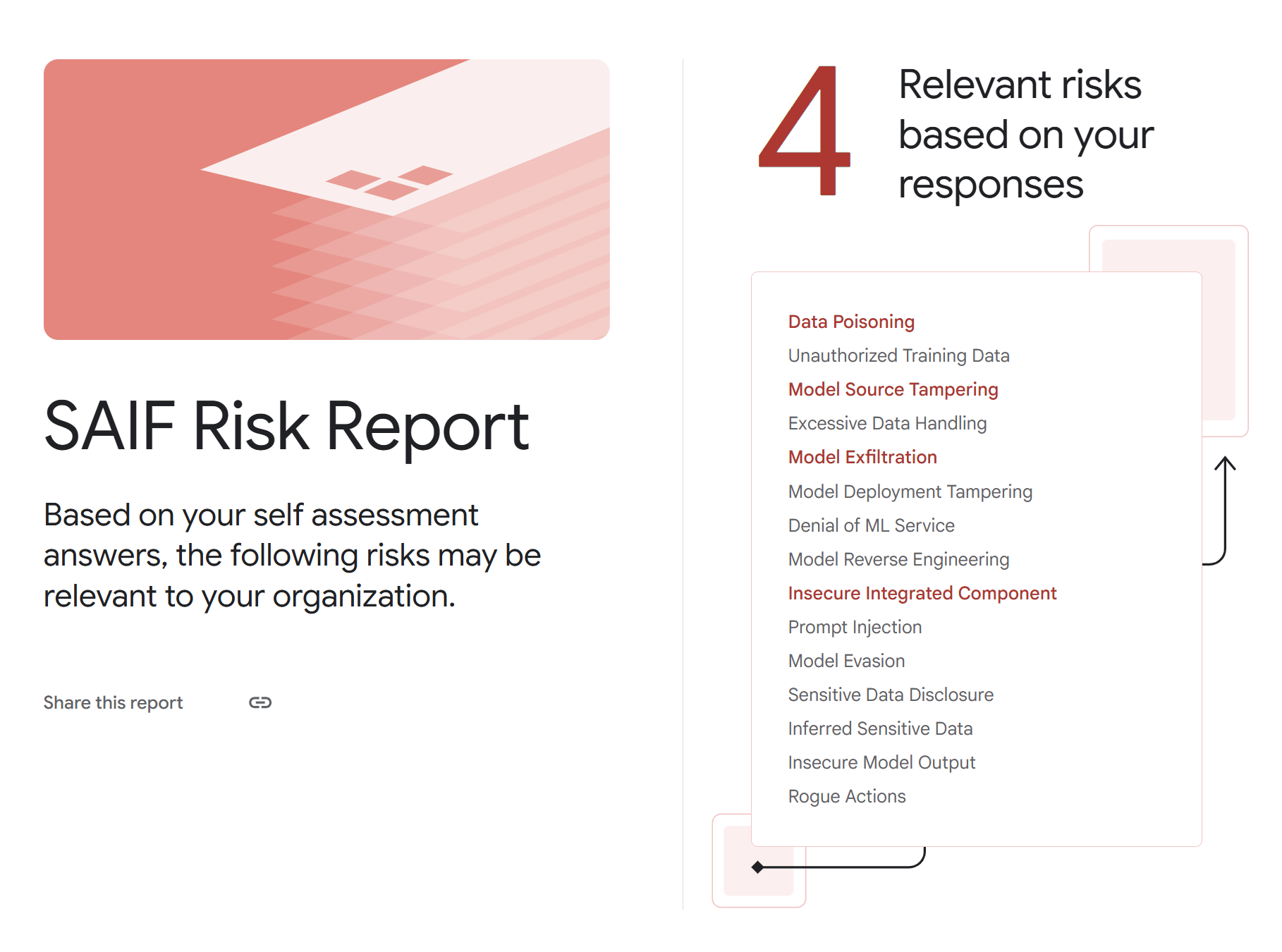

맵에서 예상되는 위험을 선택하면 [그림 4]와같이 해당 위험이 어떤 영역에서 경감 조치를 취할 수 있는지 표시해 주고, 또한 어떤 경감 방안을 고려해야 하는지 알려줍니다. 위험 측정은 12개의 항목으로 구성된 위험 측정 설문지(Risk Self-Assessment)를 통해서 [그림 5]와같이 수행할 수 있는데 그 결과가 [그림 6]에서와같이 도출이 되어서 예상되는 위험과 그에 대응하는 사전에 정의된 경감 방안도 보고서로 제공해 주는 구조입니다.

[그림 4] SAIF Map – 경감 조치 영역[5]

[그림 4] SAIF Map – 경감 조치 영역[5]

Model Creation

-

Infrastructure

MODEL + Model Storage Infrastructure

MODEL → Evaluation → Training & Tuning

Data Storage Infrastructure → Training & Tuning → MODEL

-

Data

Data Sources → Data Filtering & Processing → Data Storage Infrastructure

[그림 5] SAIF 위험 측정 설문 예시[5]

[그림 5] SAIF 위험 측정 설문 예시[5]

Risk Assessment Questions

Do you have robust access controls on all models, datasets, and related ML artifacts to minimize, detect, and prevent unauthorized reading or copying?

- select-Yes

- select-No

- select-Maybe

[그림 6] SAIF 위험 설문 결과 보고서[5]

[그림 6] SAIF 위험 설문 결과 보고서[5]

SAIF Risk Report

Based on yout self assessment answers, the following risks may be relevant to your organization.

4. Relevant risks based on your responses

- Data Poisoning

- Unauthorized Training Data

- Model Source Tampering

- Excessive Data Handling

- Model Exfiltration

- Model Deployment Tampering

- Denial of ML Service

- Model Reverse Engineering

- Insecure Integrated Component

- Prompt Injection

- Model Evasion

- Sensitive Data Disclosure

- Inferred Sensitive Data

- Insecure Model Output

- Rogue Actions

SAIF와 같이 AI 시스템을 직접 개발하는 기업의 평가 프레임워크는 정부나 연구기관이 수립한 프레임워크와 달리 해당 기업의 AI 기술 활용 방식과 프로세스에 최적화되어 있습니다. 또한 그만큼의 구체성을 가지기 때문에 AI 위험에 대한 신속한 제어와 경감 조치가 가능하다는 장점이 있습니다. 그러나 기업이 기업 자체 평가 프레임워크를 활용하더라도 AI 글로벌 규제에 이것을 끊임없이 follow-up 시킬 필요가 있으므로 외부 전문가와 커뮤니케이션을 통한 프레임워크의 업데이트가 필요합니다.

위험 기반의 AI 차등 관리 방안

지금까지 AI 위험 평가 프레임워크를 활용하여 위험을 식별하고 경감 방안까지 도출하는 실제 사례를 알아보았습니다. 결국, 위험을 평가하는 이유는 이 평가 결과를 토대로 AI 위험을 효과적으로 관리해서 실제 피해가 발생하지 않도록 예방하기 위한 것입니다. 서두에 논의했던 것처럼 AI 위험 평가 결과로 발생할 수 있는 위험과 그 수준을 예상할 수 있으면, 그에 적합한 경감 방안과 이후 관리 방안도 마련하기 용이할 것입니다. 그러면 아래에서는 EU와 우리나라의 AI 위험 수준에 따라 어떠한 조치를 취하고 있는지 그 접근 방안을 살펴보도록 하겠습니다.

EU의 AI 위험에 대한 접근 방안

상편에서 확인한 것처럼 EU는 규제법인 AI Act를 통하여 위험의 수준을 분류하고 수준별 차등화된 사업자 준수사항을 제시하고 있습니다.[6] 이런 방식은 위험 수준이 낮은 경우에도 과도한 통제로 혁신을 저해하지 않도록 하는 조치로 다른 국가들이 유사한 접근방식을 취하도록 한 선례입니다.[7] <표 2>에서 위험 수준에 따른 준수사항을 살펴보면 인간의 존엄성이나 EU의 기본 가치를 위배하는 경우 도입 자체를 금지하고 있습니다. 또한 고위험 AI에 대해서는 출시 전에 CE 마크를 획득하도록 하였습니다. 제한된 위험을 가지는 AI 시스템의 경우 투명성 조치를 취하는 수준으로 유연성을 꾀했습니다.

<표 2> EU AI ACT의 위험 수준에 따른 준수사항[6]

| 위험 유형 | 대상 | 사업자 준수사항 |

|---|---|---|

| 허용 불가능한 위험(Unacceptable risk) | 인간의 존엄성, 자유, 평등, 차별 금지, 민주주의 및 법치 존중 등 EU의 기본 가치를 위배하는 AI 시스템 |

|

| 고위험(High-risk) | 생체인식, 중요 인프라, 교육, 필수 서비스, 법 집행, 이주 및 사법에 사용되는 AI 시스템 |

|

| 제한된 위험성을 가지는 AI 시스템 | 사람과 상호작용하는 AI 시스템 중에서 딥페이크 기술과 같이 비인격화, 기만, 조작 등의 문제를 일으킬 수 있는 기술 |

|

| 범용 AI 모델(General Purpose AI Model) | 자기 감독을 사용하여 대규모 데이터로 학습된 경우를 포함하여 일반성을 가지며 다양한 고유의 작업을 유능하게 수행할 수 있고 다양한 시스템이나 애플리케이션에 통합될 수 있는 AI 모델 |

|

EU AI Act에 따르면, AI 기술을 활용하는 제품이나 서비스를 제공하는 글로벌 기업은 사전에 AI 제품 및 서비스의 위험 수준을 확인해야 합니다. 또한 이에 따라 EU AI Act에 부합하거나 더욱 강화된 자체 관리 기준을 확보해야 합니다. 무엇보다 AI 위험 수준의 객관적인 평가도 중요하므로 규제 요건에 맞는 합리적인 평가를 진행할 제3의 평가자나 평가기관을 지정하는 등의 노력도 필요하다는 점을 보여주고 있습니다.

우리나라의 위험 기반 AI 관리 동향

우리나라 인공지능기본법 논의도 EU AI ACT와 비교할 때 AI의 위험 정도를 구분하는 방식에서 유사점이 있습니다. 다만, 현재 공개된 ‘고영향’ AI의 정의가 EU의 등급 분류체계 중 ‘고위험’과 비교할 때 기본 법안에 제시된 내용만으로는 다소 모호한 측면이 있으므로 EU AI Act처럼 실효성 있는 규제를 적용하는 데는 한계가 있다는 의견도 있습니다.[8] 하지만 구체적으로 의무가 명시된 부분도 있습니다. 고영향 AI 및 생성형 AI 사업자는 AI 이용 여부에 대한 투명성과 안전성 확보 의무를 가지며, 고영향 AI와 관련한 사업자는 위험 관리 방안과 이용자 보호 방안을 수립 및 운영하여야 하고 사람이 직접 관리·감독해야 합니다.

한편, 기본법 수립 이전부터 행정기관의 각 부처에서는 AI 사용에 대한 가이드라인과 안내서를 공개하여 AI 사업자가 자율적으로 거버넌스를 구축하도록 장려하기도 했습니다. 예를 들어 금융위원회는 AI 개발·활용 안내서를 배포하였는데 이에 따르면 금융 서비스는 소비자의 재산권에 직접 연관될 가능성이 크기 때문에 위험에 대해 엄격한 규제가 필수적입니다. 또한, 금융사는 고위험 서비스(개인의 권익과 안전, 자유에 대한 중대한 위험을 초래할 수 있는 서비스)에 대해 AI 시스템을 활용하는 경우, 적절한 내부 통제 및 승인 절차를 마련하고 승인 책임자를 지정해야 합니다.[9] 최근에는 생성형 AI의 도입이 활성화되면서 고위험에 준하는 부작용이 예상되고 있습니다. 이에 대해 가이드라인과 안내서를 마련하기 위한 정부 부처 및 연구기관 등의 노력도 진행 중입니다. 이를 활용하여 기업은 생성형 AI에 대해서도 필요한 윤리 기준과 안전장치를 업데이트하고 위험 관리 체계를 재점검하여 새롭게 등장하는 위험에 대한 선제적인 조치를 취할 수 있습니다.

안전한 AI 사업을 위한 제안

국내 기업들이 최근 AI의 안전성과 신뢰성을 확보하는 데 많은 관심을 기울임에 따라, 기업 차원의 AI 거버넌스 체계를 수립하는 사례가 증가하고 있습니다. 특히, 양질의 데이터를 기반으로 다양한 AI 서비스를 제공함으로써 금융소비자의 편익을 도모하는 금융사의 경우 다른 산업에 비해 선제적으로 AI 거버넌스 수립을 추진하고 있습니다. 인공지능기본법의 제정으로 AI 시스템의 투명성과 안전성을 확보하는 것은 비단 금융사뿐 아니라 AI 서비스를 제공하거나 사용하는 모든 기관에게 필요한 일이 되었습니다. 해당 기관은 각자의 비즈니스 영역에 적합한 위험 프레임워크를 수립한다면 AI 위험을 인식하고 위험 수준에 부합하는 효과적인 관리 방안을 마련할 수 있을 것입니다.

삼성SDS는 수년간 AI 거버넌스 컨설팅을 통해 기업의 윤리 원칙을 수립하고 AI 거버넌스 운영 프로세스와 조직 간 R&R, 위험 관리 프레임워크의 수립, 실무자를 위한 툴과 검증 지표를 제공해 왔습니다. 특히, 최근 생성형 AI 활용 시 필요한 다양한 안전조치 기법 등을 마련하였고, 이를 플랫폼으로도 구현하여 서비스하고 있습니다. AI 제품 및 서비스를 제공하는 사업자는 자체적으로 지금까지 논의된 사례를 참고하여 해당 사업의 특성에 가장 효율적인 AI 거버넌스 체계 수립을 통해 AI 위험 관리 프레임워크를 개발하고 경감 조치를 마련할 수 있습니다. 또한, 삼성SDS와 같이 경험이 풍부한 전문 컨설팅 사업자를 통해 보다 신속하고 안전하게 AI 위험 관리 방안을 마련하는 데 도움을 받을 수도 있을 것입니다.

독일의 사회학자 울리히 벡은 <위험사회>에서 근대화 이후의 위험은 기존의 자연적 재난과는 다르다고 설명합니다. 성공적인 근대화 과정에서 정치, 경제, 사회, 기술적으로 무궁무진한 변화가 일어났으며 이러한 변화의 산물이 바로 위험이라는 것입니다.[10] 그는 급속히 발달하는 과학기술은 문제이자 해결책으로 동시에 작동한다고 해석합니다. 즉, 과학기술은 인간이 본래 그것을 탐구했던 의도와는 무관하게 부작용을 발생시키기도 하지만 그 기술을 다른 방면에서는 부작용을 극복하는 데도 활용할 수 있다는 의미입니다. AI 기술 또한 이와 다르지 않을 것입니다. AI로 인해 발생할 수 있는 부정적인 사건을 예방하는 것은 AI 기술을 발전시키고 적소에 사용하는 것만큼이나 중요할 것입니다.

상편부터 하편까지 논의해 온 AI 위험의 인식과 수준의 평가, 또 이에 부합하는 관리 방안들은 궁극적으로는 AI 기술의 제공자와 사용자 모두가 안전하게 AI를 활용하기 위해 필요한 지침입니다. 우리는 자칫 블랙박스가 될 수 있는 AI에 보다 투명하게 접근함으로써 위험을 최소화하면서 인간을 돕는 데 최적화된 역할을 맡겨야 합니다. 결국 AI 위험 관리는 기술과 인류의 공생이자, 육성과 규제의 갈림길에 선 기술에 대한 이정표라고 해석됩니다.

References

[1] B. Attard-Frost et al. “The governance of artificial intelligence in Canada: Findings and opportunities from a review of 84 AI governance initiatives,” (2024)

[2] Canada Government(2024). Algorithm Impact Assessment tool(AIA)

[3] https://open.canada.ca/aia-eia-js/?lang=en

[4] Future of Life Institute(2024). FLI AI Safety Index

[5] https://saif.google/secure-ai-framework

[6] European Parliament(2024). EU Artificial Intelligence Act

[7] 소프트웨어정책연구소(2024). 유럽연합 인공지능법(EU AI Act)의 주요내용 및 시사점

[8] 법무법인 태평양(2025). 인공지능기본법 통과의 의의 및 산업계에 미칠 영향

[9] 금융위원회(2022). 금융분야 AI 개발 · 활용 안내서

[10] 울리히 벡(1986). 위험사회

▶ 이 글은 저작권법에 의하여 보호받는 저작물로 모든 저작권은 저작자에게 있습니다.

▶ 이 글은 사전 동의 없이 2차 가공 및 영리적인 이용을 금하고 있습니다.

![]()

정유진 | 삼성SDS 금융컨설팅팀

AI First를 모토로 AX (AI Transformation) 컨설팅을 수행하고 있습니다. 기업의 더욱 안전하고 유익한 AI 활용을 위해 AI Agent, AI 거버넌스 플랫폼 설계에도 참여하고 있으며, 최근에는 AI 위험 수준 평가에 대한 글로벌 동향에 관심을 가지고 연구와 자유기고를 병행하고 있습니다.

조남용 | 삼성SDS 금융컨설팅팀

기업 고객을 대상으로 AI, Digital Transformation 컨설팅을 담당해 왔습니다. 최근에는 AI 사업자 및 이용자가 보다 안전하게 AI를 활용할 수 있는 환경을 제공하고자 AI 위험 평가, 생성형 AI 신뢰성 검증 및 시스템 구현 등에 관한 연구 및 컨설팅을 수행하고 있습니다.