인공지능 재앙을 막아라! 23가지 AI 원칙

2017년 1월 인공지능(AI, Artificial Intelligence)에 대한 연구를 지원하는 한 비영리단체가 주최한 콘퍼런스에서 저명한 IT 관계자들이 원칙을 만들었습니다. 바로 아실로마 AI 원칙(Asilomar AI Principles) 인데요. 인공지능에 대한 연구가 활발할수록 그에 대한 경계심도 커지고 있는 요즘, 아실로마 AI 원칙이 무엇인지, 어떤 의미가 있는지 살펴보겠습니다!

물리학자인 스티븐 호킹, 테슬라의 최고경영자 일론 머스크, 알파고를 개발한 구글 딥마인드의 데미스 하사비스 최고경영자 등 총 2,000명의 과학계, 기술계 인사들이 아실로마 AI 원칙 에 지지 서명을 남겼습니다.

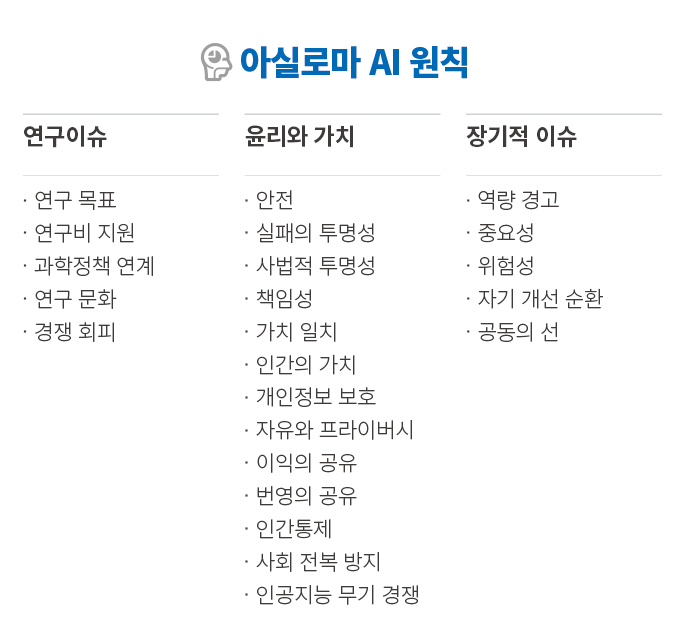

아실로마 AI 원칙이란 인공지능(AI) 기술에 대한 23개 준칙으로 미국 캘리포니아 아실로마에서 열린 AI 콘퍼런스(beneficial AI 2017)에서 채택됐는데요. 이 원칙은 연구 이슈(5개), 윤리와 가치(13개), 장기 이슈(5개) 등 총 3부분으로 구성돼 있습니다.

첫째인 연구 이슈는 아실로마 원칙이 추구하는 방향이 담겨있습니다. 인간에게 유용하고 이로운 혜택을 주는 지능을 개발하는 것을 목표로 하고 있죠. 둘째, 윤리와 가치는 AI를 개발하는 과정에서 발생할 수 있는 실패와 자유의 침해에 대해 책임성 있게 행동하길 강조하고 있습니다. 마지막 장기적 이슈는 인공지능이 가져올 장기적인 문제를 포함하는데 우선 합의된 여론 없이 미래 인공지능이 인류를 멸망하게 한다는 등 강력한 가설은 삼가야 한다고 정했습니다.

아실로마 준칙은 AI의 급부상과 함께 제기되는 문제점들이 지지 배경이 됐는데요. AI 기술이 발전하면서 인간의 삶이 좀 더 편해지고 적용 가능한 분야도 많아지고 있지만, 한편으론 AI가 가져올 각종 문제에 대한 우려의 목소리가 커지고 있는 상황입니다.

AI가 인간의 노동력을 대체할 수 있다는 문제 제기부터, AI가 접목된 아직은 미숙한 자동차, 디바이스들이 유발하는 사고까지 AI가 불러오는 걱정과 경계심은 다양합니다. 각종 SF 영화에서 인공지능이 인간을 공격하는 것을 소재로 삼고 있는 것처럼 말이죠.

그래서 윤리와 가치가 가장 많은 항목을 담고 있다는 생각도 문득 드는데요. 윤리와 가치 부분에 대한 원칙을 보시면 어떤 부분이 우려되고 또 걱정을 해소하기 위해 원칙을 만들었는지 그 의미를 알 수 있습니다. 몇 가지 항목만 살펴볼까요?

| Safety : AI systems should be safe and secure throughout their operational lifetime, and verifiably so where applicable and feasible.

Failure Transparency : If an AI system causes harm, it should be possible to ascertain why. Responsibility : Designers and builders of advanced AI systems are stakeholders in the moral implications of their use, misuse, and actions, with a responsibility and opportunity to shape those implications. Human Values : AI systems should be designed and operated so as to be compatible with ideals of human dignity, rights, freedoms, and cultural diversity. Shared Benefit : AI technologies should benefit and empower as many people as possible. Non-subversion : The power conferred by control of highly advanced AI systems should respect and improve, rather than subvert, the social and civic processes on which the health of society depends. AI Arms Race : An arms race in lethal autonomous weapons should be avoided. – 아실로마 AI 원칙 원문 : https://futureoflife.org/ai-principles/ |

얼마 전 미국의 한 주 대법원이 AI가 분석한 자료를 근거로 피고인에게 중형을 선고한 사례가 있었습니다. 그만큼 인공지능이 인간의 삶과 밀접한 관련을 맺고 있는데요. 인공지능이 인간 사회의 가치관과 법칙을 존중하도록 만드는 것이 중요한 지금! 인공지능에 대한 강력한 통제와 인류의 이익을 강조하는 아실로마 AI 원칙이 중요한 기준을 제시한다고 불 수 있겠네요!

글 삼성SDS 대학생 기자단 9기 최연준