AI 기술의 발전은 우리의 일상과 업무 수행 방식을 혁신적으로 변화시키고 있습니다. ChatGPT와 같은 대규모 언어 모델(LLM)의 도입은 애플리케이션 개발에 새로운 가능성을 열어주었습니다. 그러나 이러한 기술의 발전은 동시에 새로운 도전 과제를 가져왔습니다. 기존 언어 모델은 단순한 텍스트 생성에 머무르는 경우가 많다 보니, 이를 실제 애플리케이션에 통합할 때에는 여러 가지 제약이 따랐습니다. 이 같은 배경 속에서 등장한 LangChain이라는 프레임워크는 이러한 한계를 극복하고, 언어 모델을 활용한 스마트 애플리케이션 구축을 가능하게 하며, 새로운 패러다임을 제시하고 있습니다. 이 글에서는 AI 시대의 변화와 함께 LangChain이 어떻게 언어 모델의 한계를 극복하고 실질적인 애플리케이션 개발을 가능하게 하는지 살펴보겠습니다.

LangChain(랭체인)이란 무엇인가?

LangChain(랭체인)은 대규모 언어 모델(LLM)을 활용한 애플리케이션 개발에 특화된 오픈소스 프레임워크입니다. LangChain은 기존 언어 모델의 한계를 극복하고, AI 기술을 활용한 새로운 애플리케이션을 구축할 수 있는 중요한 도구로 자리 잡고 있습니다. LLM의 잠재력을 극대화하여 실질적인 애플리케이션을 구축할 수 있도록 지원하는 LangChain은 특히 OpenAI의 GPT-4나 Hugging Face 모델과 같은 대규모 언어 모델을 효과적으로 통합하는 데 중점을 둡니다. 기존의 언어 모델이 주로 텍스트 생성에 중점을 둔 반면, LangChain은 다양한 외부 데이터 소스와 통합하여 보다 복잡하고 유용한 애플리케이션을 만들 수 있도록 설계되었습니다. LLM의 잠재력을 극대화하기 위해 데이터베이스, 파일 시스템 등과 같은 다양한 데이터 소스와의 통합을 지원하여, 실시간 데이터와 상호작용하는 애플리케이션을 구축할 수 있습니다. 이러한 통합은 언어 모델이 단순한 텍스트 응답을 넘어, 사용자에게 보다 정확하고 유의미한 정보를 제공하는 애플리케이션을 가능하게 합니다. LangChain을 통해 개발자는 더 복잡한 사용 사례를 처리할 수 있는 애플리케이션을 손쉽게 구축할 수 있습니다.

LangChain은 오픈소스 프로젝트로서, 전 세계 개발자들이 참여하고 기여하는 커뮤니티에 의해 지속적으로 발전하고 있습니다. 이 커뮤니티는 AI 기술의 최신 동향을 반영하여 새로운 기능을 추가하고, 기존 기능을 개선하며, 다양한 사용 사례를 공유하여 LangChain의 발전을 이끌고 있습니다. 이는 LangChain이 시장에서 경쟁력을 유지하고, 다양한 산업에서 지속적으로 사용될 수 있도록 하는 데 중요한 역할을 합니다. 또한, LangChain의 중요성은 유연성과 확장성에도 있습니다. LangChain은 다양한 데이터 소스와의 원활한 통합을 지원하며, 복잡한 애플리케이션을 구축하는 데 필요한 유연성을 제공합니다. 이로 인해 개발자들은 특정 비즈니스 요구에 맞춘 맞춤형 솔루션을 쉽게 개발할 수 있습니다.

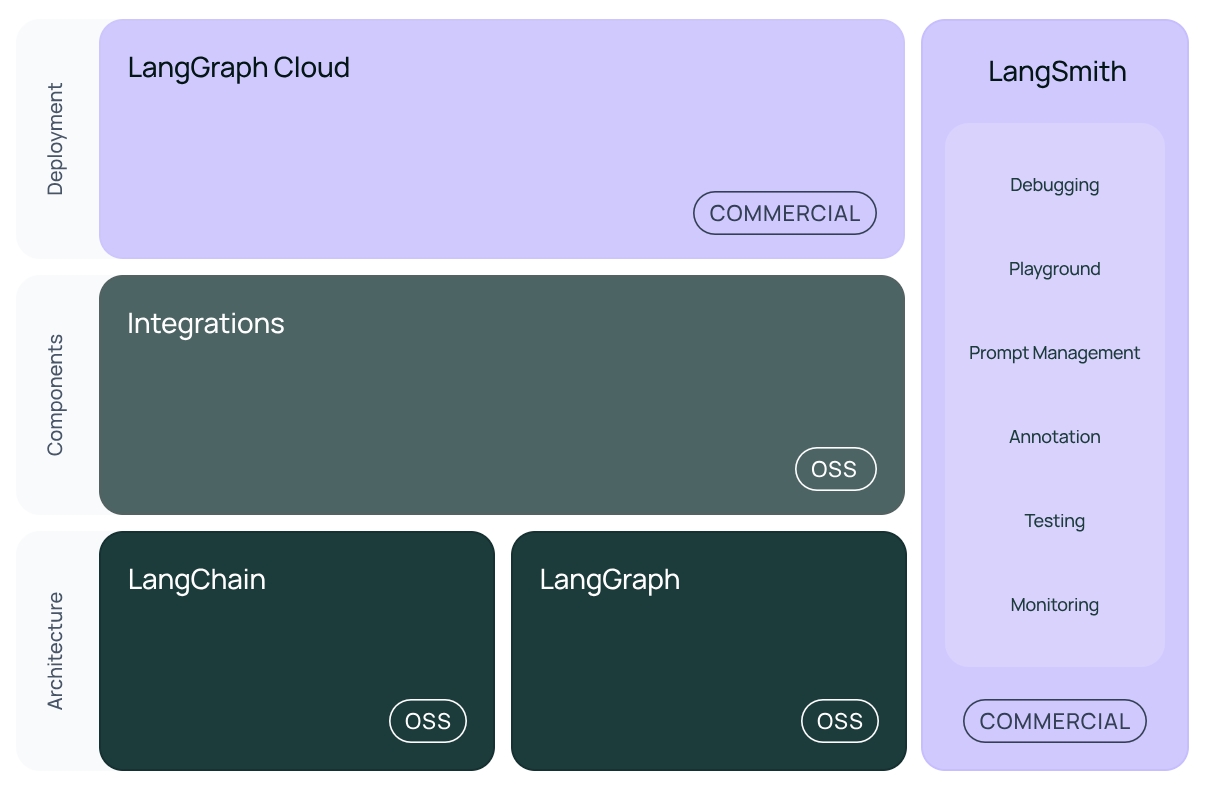

LangChain의 기본 프레임워크

LangChain은 기본적으로 간소화된 LLM 애플리케이션 라이프사이클을 제공하며, 다음과 같은 오픈소스 라이브러리로 구성합니다.

• 개발: LangChain의 오픈소스 빌딩 블록, 컴포넌트, 서드파티 통합 등을 사용하여 애플리케이션을 빌드합니다.

* langchain: 애플리케이션의 코그너티브 아키텍처를 구성하는 체인, 에이전트 및 검색 전략

* langchain-core: 기본 추상화 및 LangChain 표현 언어

* langchain-community: 서드파티 통합 (langchain-openai, langchain-anthropic 등)

• 테스트: LangSmith를 사용하여 체인을 검사, 모니터링 및 평가합니다.

* LangSmith: LLM 애플리케이션을 디버깅, 테스트, 평가, 모니터링할 수 있는 개발자 플랫폼입니다.

• 배포: LangGraph Cloud를 사용하여 LangGraph 애플리케이션을 프로덕션에 바로 사용할 수 있는 API와 Assistant로 전환합니다.

* LangGraph: 그래프의 에지와 노드로 단계를 모델링하여 LLM으로 견고한 “stateful” 멀티 액터 애플리케이션을 구축합니다.

* LangServe: LangChain 체인을 REST API로 배포합니다.

[그림 1] LangChain의 기본 프레임워크 (출처: langchain.com)

[그림 1] LangChain의 기본 프레임워크 (출처: langchain.com)

LangGraph Cloud

commercialIntegrations

ossLangChain

ossLangGraph

oss- Debugging

- Playground

- Prompt Managemnet

- Annotation

- Testing

- Monitoring

LangChain의 주요 기능

LangChain은 다음과 같은 기능들을 통해 다양한 산업에서 혁신적인 애플리케이션을 구축할 수 있는 강력한 도구로 자리 잡고 있습니다. 개발자들은 LangChain을 활용해 더욱 유연하고 확장 가능한 솔루션을 만들어낼 수 있습니다.

다양한 데이터 소스와의 통합

LangChain은 다양한 데이터 소스와의 원활한 통합을 지원하는 강력한 기능을 제공합니다. 이를 통해 데이터베이스, API, 파일 시스템 등 다양한 소스의 데이터를 실시간으로 활용할 수 있습니다. 이러한 통합은 사용자에게 더욱 정확하고 관련성 높은 정보를 제공하는 데 필수적이며, 애플리케이션이 복잡한 데이터를 실시간으로 처리하고 활용할 수 있게 합니다. 예를 들어, 금융 서비스에서 실시간 시장 데이터를 분석하거나, 의료 분야에서 환자 기록을 즉각적으로 조회하고 분석하는 애플리케이션을 구축할 수 있습니다.

유연한 프롬프팅 및 컨텍스트 관리

LangChain은 LLM을 효과적으로 활용하기 위한 유연한 프롬프팅과 컨텍스트 관리 도구를 제공합니다. 이러한 도구는 언어 모델이 사용자 질문에 대해 더욱 정확하고 맞춤형 응답을 생성할 수 있도록 돕습니다. 프롬프팅 기능은 사용자와의 대화를 보다 자연스럽고 연속성 있게 만들어주며, 복잡한 대화 흐름에서도 일관된 컨텍스트를 유지할 수 있게 합니다. 이를 통해 고객 지원 챗봇이나 인터랙티브한 학습 도우미와 같은 애플리케이션에서 사용자 경험을 크게 향상할 수 있습니다.

파인튜닝 및 커스터마이징

LangChain은 특정 작업에 맞춘 언어 모델을 구축하기 위해 파인튜닝과 커스터마이징 기능을 제공합니다. 이 기능은 사용자가 특정 비즈니스 요구에 맞는 모델을 세밀하게 조정할 수 있도록 도와줍니다. 예를 들어, 특정 산업의 전문 용어를 이해하고 그에 따라 응답을 생성하도록 언어 모델을 파인튜닝할 수 있습니다. 또한, LangChain은 다양한 모델을 쉽게 교체하거나 조정할 수 있는 유연성을 제공하므로, 애플리케이션의 요구에 맞춰 모델을 최적화할 수 있습니다.

데이터 반응형 애플리케이션 구축

LangChain은 실시간 데이터와 상호작용하는 데이터 반응형 애플리케이션을 구축할 수 있는 기능을 제공합니다. 이러한 애플리케이션은 사용자가 입력한 정보를 즉각적으로 처리하고, 그에 따라 실시간으로 반응하는 시스템을 구현할 수 있게 해줍니다. 예를 들어, 실시간 시장 변화에 따라 자동으로 투자 전략을 조정하는 금융 애플리케이션이나, 사용자 입력에 기반해 실시간으로 맞춤형 학습 콘텐츠를 제공하는 교육 플랫폼을 개발할 수 있습니다.

LangChain의 장점과 단점

LangChain은 강력하고 유연한 도구로, 다양한 언어 모델과의 통합을 통해 복잡한 애플리케이션을 구축하는 데 매우 유용합니다. 그러나 성능 최적화 및 학습 곡선의 문제와 같은 단점도 존재하므로, 이를 고려하여 프로젝트에 적합한 도구인지 판단하는 것이 중요합니다.

LangChain의 장점

LangChain은 다양한 언어 모델과 쉽게 통합할 수 있으며, 이를 통해 복잡하고 다양한 애플리케이션을 구축할 수 있습니다. 이 프레임워크는 OpenAI의 GPT-4나 Hugging Face 모델과 같은 대규모 언어 모델과 원활하게 통합되어, 사용자가 필요에 따라 모델을 확장하고 조정할 수 있는 높은 확장성을 제공합니다. 이는 특히 다양한 데이터 소스와의 통합을 통해 애플리케이션이 여러 복잡한 작업을 수행할 수 있게 해줍니다.

LangChain은 프롬프팅, 컨텍스트 관리, 파인튜닝 등 다양한 기능을 제공하여 사용자가 필요에 따라 애플리케이션의 동작을 세밀하게 조정할 수 있는 높은 유연성을 자랑합니다. 이러한 유연성은 다양한 산업 분야에서 맞춤형 솔루션을 구현하는 데 중요한 역할을 합니다. 또한, LangChain은 여러 언어 모델과의 통합이 가능하여, 다양한 사용 사례에 맞춘 애플리케이션을 쉽게 구축할 수 있습니다.

LangChain은 활발한 오픈소스 커뮤니티에서 지원을 받고 있습니다. 이 커뮤니티는 지속적인 업데이트와 개선을 통해 LangChain의 기능을 확장하고, 다양한 문제 해결에 도움을 줍니다. 또한, 개발자들이 서로의 경험을 공유하고, 문제를 해결하는 데 큰 도움이 되는 다양한 리소스를 제공받을 수 있습니다. 커뮤니티의 지원 덕분에 LangChain은 빠르게 성장하고 있으며, 개발자들이 최신 기술을 활용할 수 있도록 돕습니다.

LangChain의 단점

LangChain은 매우 복잡한 애플리케이션을 구축할 때 성능 저하가 발생할 수 있습니다. 특히, 대규모 데이터 소스를 처리하거나 실시간 응답을 요구하는 애플리케이션의 경우, 성능 최적화가 필요할 수 있습니다. 이는 LangChain이 다수의 외부 데이터 소스와 통합되면서 발생하는 추가적인 연산 부담 때문이며, 성능을 높이기 위해 추가적인 하드웨어 리소스나 코드 최적화가 필요할 수 있습니다.

LangChain을 처음 사용하는 개발자들에게는 이 프레임워크가 다소 복잡하게 느껴질 수 있습니다. 특히, 다양한 기능과 옵션을 활용하기 위해서는 일정한 학습 시간이 필요하며, 이를 효과적으로 사용하기 위해서는 깊이 있는 이해가 요구됩니다. 이로 인해 초보자나 작은 프로젝트를 진행하는 개발자들에게는 부담이 될 수 있습니다.

LangChain은 특정 사용 사례에 적합하도록 설계되었지만, 모든 상황에 완벽하게 맞는 것은 아닙니다. 예를 들어, 특정 산업에서 요구하는 고도로 특화된 기능이 LangChain에서 기본적으로 제공되지 않을 수 있으며, 이를 구현하기 위해서는 추가적인 커스터마이징이 필요할 수 있습니다. 또한, 일부 사용 사례에서는 성능, 비용, 복잡도 등의 이유로 다른 솔루션이 더 적합할 수도 있습니다.

LangChain 시작하기: LangChain 설치

Windows에서 비교적 가볍게 LangChain을 시작해 볼 수 있습니다. LangChain을 시작하기 위해서는 Python 설치가 필요합니다. 아래 단계는 Windows PowerShell을 사용하여 진행됩니다.

(1) Python 설치

먼저 Python 공식 웹사이트에서 Python 3.8 이상 버전을 다운로드하여 설치합니다. 설치 시 "Add Python to PATH" 옵션을 선택합니다.

(2) LangChain 설치

Windows PowerShell 명령 프롬프트 창에서 다음 명령어를 입력하여 LangChain을 설치합니다. 이렇게 하면 LangChain의 최소 요구사항이 설치됩니다. 특정 통합을 위해서는 별도로 라이브러리 패키지를 설치해야 합니다.

pip install langchain

(3) 서드파티 설치: OpenAI

OpenAI에서 제공하는 LLM을 사용한다고 가정하면, 다음 명령어를 입력하여 OpenAI 라이브러리를 설치합니다. 다른 업체에서 제공하는 라이브러리는 아래 표를 참조해 주세요.

pip install langchain-openai

<표 1> LangChain 서드파티 라이브러리

| 제공업체 | 라이브러리명 |

|---|---|

| Anthropic LLM | - langchain-anthropic |

| AWS Bedrock LLM | - langchain-aws |

| Cohere LLM | - langchain-cohere |

| Fireworks LLM | - langchain-fireworks |

| Google LLM | - Google Generative AI: langchain-google-genai - Vertex AI: langchain-google-vertexai |

| Hugging Face LLM | - langchain-huggingface |

| IBM LLM | - langchain-ibm |

| Microsoft AzureOpenAI LLM | - langchain-openai |

| Ollama LLM | - langchain-ollama |

| OpenAI LLM | - langchain-openai |

LangChain을 통해 스마트 애플리케이션으로 확장

LangChain을 통해 효과적인 스마트 애플리케이션으로 확장할 수 있으며, 다양한 산업 분야에서 혁신적인 솔루션을 구축하는 데 도움을 줄 수 있습니다.

다양한 데이터 소스 통합

LangChain은 다양한 데이터 소스를 통합하여 복잡한 애플리케이션을 구축하는 데 매우 효과적입니다. 이를 통해 실시간 데이터, API, 데이터베이스, 파일 시스템 등에서 데이터를 가져와 언어 모델에 통합할 수 있습니다.

• 다중 데이터 소스 통합 : LangChain은 여러 데이터 소스를 동시에 통합할 수 있는 기능을 제공합니다. 예를 들어, 데이터베이스에서 사용자 데이터를 가져오고, API에서 실시간 데이터를 불러와, 이를 언어 모델이 처리할 수 있도록 설정할 수 있습니다. 이러한 기능은 특히 실시간으로 다양한 정보를 처리해야 하는 애플리케이션에 유용합니다.

• 데이터베이스 연결 : LangChain은 SQL 및 NoSQL 데이터베이스와의 연결을 지원하며, 이를 통해 데이터베이스에서 직접 데이터를 검색하고 이를 언어 모델에 활용할 수 있습니다.

맞춤형 프롬프팅 및 파인튜닝

프롬프팅과 파인튜닝은 LangChain을 통해 사용자에게 맞춤형 응답을 제공하기 위한 핵심 전략입니다. 이 전략을 통해 언어 모델이 특정 사용 사례에 맞게 동작하도록 조정할 수 있습니다.

• 프롬프팅 설계 : 사용자의 질문에 정확히 응답하기 위해서는 프롬프트 설계가 중요합니다. 프롬프트에 충분한 컨텍스트와 구체적인 지침을 포함시켜 모델이 적절한 답변을 생성하도록 합니다. 예를 들어, 특정 산업의 용어를 이해하는 모델이 필요할 경우, 그에 맞는 프롬프트를 설계하여 모델이 올바른 응답을 할 수 있도록 유도합니다.

• 파인튜닝 : 특정 작업에 특화된 모델을 만들기 위해 파인튜닝을 사용할 수 있습니다. 예를 들어, 특정 도메인 지식을 학습한 모델을 생성하여 더 정확한 응답을 제공할 수 있습니다. 파인튜닝을 통해 모델이 특정 데이터셋에서 더욱 정교하게 학습하도록 할 수 있습니다.

실시간 데이터와의 상호작용 구현

LangChain은 실시간 데이터와의 상호작용을 통해 사용자에게 최신 정보를 제공할 수 있는 애플리케이션을 구축하는 데 매우 유용합니다.

• 실시간 데이터 통합 : API를 통해 실시간 데이터를 언어 모델에 제공하여, 사용자가 요청할 때마다 최신 정보를 기반으로 응답을 생성할 수 있습니다. 이는 금융, 뉴스, 날씨 등 실시간 정보가 중요한 애플리케이션에서 특히 유용합니다.

• 데이터 반응형 애플리케이션 : LangChain을 통해 구축된 애플리케이션은 실시간 데이터와 지속적으로 상호작용할 수 있으며, 이를 통해 사용자가 필요한 순간에 정확하고 관련성 높은 정보를 제공받을 수 있습니다. 이러한 기능은 사용자 경험을 크게 향상하며, 비즈니스 성과에도 긍정적인 영향을 미칠 수 있습니다.

LangChain을 활용한 애플리케이션 구축 사례

LangChain은 현재 다양한 산업 분야에서 사용되고 있으며, 앞으로도 지속적인 발전이 기대됩니다.

Morningstar: 맞춤형 금융 인사이트

LangChain은 고객의 요구에 맞춘 맞춤형 솔루션을 제공할 수 있어, 고객 경험을 크게 개선할 수 있습니다. 금융 서비스 제공업체 Morningstar는 LangChain을 사용해 방대한 재무 보고서와 시장 데이터를 분석하고, 이를 바탕으로 사용자 맞춤형 금융 인사이트를 제공하는 인텔리전스 엔진을 개발했습니다. 이 시스템은 금융 전문가들이 복잡한 질문에 대해 정확한 답변을 얻을 수 있도록 도와주며, LangChain의 실시간 데이터 통합과 맞춤형 프롬프팅 기능을 효과적으로 활용하고 있습니다.

NCL: 최적화된 여행 계획 제공

LangChain은 사용자 맞춤형 프롬프팅 및 파인튜닝 기능을 통해 특정 산업의 요구에 맞춘 솔루션을 제공합니다. NCL(노르웨이 크루즈 라인)은 LangChain을 이용해 고객들이 이상적인 크루즈 여행을 계획할 수 있도록 돕는 AI 어시스턴트를 개발했습니다. 이 시스템은 고객의 선호도와 탐색 기록을 기반으로 맞춤형 추천을 제공하며, LangChain을 통해 실시간으로 변화하는 고객 요구에 대응할 수 있습니다.

Elastic: 운용 효율성 향상

LangChain은 다양한 데이터 소스와의 통합을 통해 실시간으로 데이터를 처리하고 분석할 수 있어, 비즈니스 운영의 효율성을 크게 향상합니다. Elastic은 보안 분석가들을 지원하기 위해 LangChain을 활용해 AI 어시스턴트를 개발했습니다. 이 AI 어시스턴트는 보안 경고를 요약하고, 워크플로우를 제안하며, 쿼리 생성과 변환을 수행하여 보안 팀의 업무 효율성을 크게 향상합니다. 이 애플리케이션은 실시간으로 대량의 데이터를 처리하고 분석하여 보안 작업을 지원하는데, LangChain의 데이터 통합 및 처리 기능이 중요한 역할을 하고 있습니다.

결론

LangChain은 AI 및 LLM 분야에서 중요한 역할을 하고 있으며, 앞으로도 다양한 산업에서 그 사용이 확대될 것입니다. 고급 통합 기능과 사용자 경험 개선을 통해 더욱 정교한 애플리케이션을 개발할 수 있을 것이며, 오픈소스 커뮤니티의 기여로 지속적인 혁신이 이루어질 것입니다. 이를 통해 LangChain은 AI 기술의 발전과 함께 시장에서 중요한 위치를 계속해서 유지할 것입니다.

한편, LangChain은 이미 다양한 데이터 소스와의 통합을 지원하지만, 향후에는 더욱 고도화된 통합 기능이 개발될 것으로 예상됩니다. 이는 더욱 복잡한 데이터 환경에서도 높은 성능을 유지하면서 확장성을 제공하는 방향으로 발전할 가능성이 큽니다. LangChain은 계속해서 새로운 기능과 도구를 도입할 것입니다. 예를 들어, 실시간 데이터 분석과 반응형 애플리케이션 구축을 위한 도구들이 더 발전할 수 있습니다. 이는 AI와 LLM을 활용한 비즈니스 애플리케이션의 범위를 넓히는 데 기여할 것입니다.

▶ 이 글은 저작권법에 의하여 보호받는 저작물로 모든 저작권은 저작자에게 있습니다.

▶ 이 글은 사전 동의 없이 2차 가공 및 영리적인 이용을 금하고 있습니다.

![]()

삼성SDS 전략마케팅팀

Corporate Strategy & Business Development, and Customer Success Lead