클라우드는 중앙에 고성능의 컴퓨터 시스템을 성능이 떨어지는 그 어떤 기기에서든 사용할 수 있도록 해준다. 우리가 직접 조작해서 사용하는 기기는 네트워크 연결 기능과 함께 최소의 입력장치(마이크)와 출력장치(스피커나 작은 프로젝터 혹은 미니 디스플레이 등)만 있으면 클라우드 자원을 마음껏 가져다 사용할 수 있다. 극 효율적인 시스템이다. 그런데, 세상만사 다 그렇게 꿈처럼 실현되지는 않는다. 그 한계가 명확하기 때문이다. 그래서, 엣지 컴퓨팅이 주목받고 있다. 특히, AI가 알파고에서 챗GPT로 초 거대화되면서 클라우드의 성능이 더욱 좋아졌을 뿐만 아니라 엣지 컴퓨팅도 새로운 전환의 계기가 만들어지고 있다.

기업을 위한 sLLM 시장의 형성

2023년은 ChatGPT로 시작해서 챗GPT로 마감되었다 해도 과언이 아닐 만큼 IT를 넘어 전 세계적인 트렌드가 되었다. 그런 ChatGPT를 가능하게 한 AI가 바로 LLM(Large Language Model)이다. 그런 LLM은 아무나 만들기 어렵다. 그만큼 GPU 인프라와 데이터가 필요한 데다 기술력도 있어야 하기에 전 세계적으로 그런 LLM을 만드는 빅테크 기업은 손으로 꼽는다. 돈과 기술력이 있는 구글, Microsoft, 메타 그리고 테슬라와 한국의 네이버, SKT, 삼성전자, LG전자 정도이다. 물론 이들만큼의 거대 기술기업이 아님에도 불구하고 발 빠른 준비와 오직 LLM 기술 개발에 집중해 성과를 거두는 오픈AI, 앤쓰로픽, 코히어 그리고 국내의 업스테이지 등과 같은 스타트업들도 있다. 그렇게 초거대 LLM(FM: Foundation Model)은 새로운 기회보다는 자리 잡은 스타트업과 기득권을 가진 빅테크 기업들로 시장이 고착화되며 이들 간 경쟁이 심화하고 있다.

하지만, 더 이상 LLM 시장의 기회는 없는 것일까? LLM은 사람처럼 무엇이든 할 수 있는 잠재력이 무궁무진하다. 그래서 LLM은 할 수 있는 일이 다양하며 그로 인해 세상이 놀랐던 것이다. 2016년의 알파고도 놀랄만한 성능이었지만 그것은 오직 바둑만 잘 둘 뿐이었는데 LLM은 번역, 수학, 요약, 창작, 검색, 추론, 분석 등 다양한 작업 수행이 가능하다. 그런데, 그렇게 만능의 LLM이 늘 좋은 것만은 아니다. LLM을 개발하고 운영하는데 너무 많은 컴퓨팅 리소스, 인프라를 필요로 하기 때문이다. 또한, 뭐든 할 수 있다는 것은 어떤 것도 완벽하게 해낼 수 없다는 말이기도 하다. 너무 많은 것을 할 수 있기에 할루시네이션으로 인한 에러도 감수해야 한다.

불특정 다수의 모든 이들에게 서비스를 제공할 때 LLM은 훌륭한 대안이 될 수 있지만, 특정한 비즈니스 문제를 해결하는 기업 입장에서는 비용과 에러로 인한 이 기술을 무작정 채택하기엔 부담이 된다. 게다가 모든 것을 빨아들이는 이 LLM에 자칫 종속되면 기업의 보안 문제뿐 아니라 비즈니스의 독립성도 해칠 우려가 있다. 그래서, 개별 기업의 특수성을 고려한 small LLM에 대한 기회가 싹트고 있다.

특히 보안이 중요한 금융업과 환자 생명과 안전이 중요한 의료업(이런 분야에 할루시네이션이 발생하면 끔찍) 등에서는 자체적인 sLLM 구축이 성행하고 있다. 물론 이런 sLLM은 LLM보다는 적은 비용으로 기업 목적에 맞는 운영이 가능하다. 단, LLM처럼 이것저것 다 잘할 수는 없다. 그렇게 기업별 sLLM 구축에 대한 다양한 시도가 본격화되고 있다.

sLLM으로 주목받을 On-device AI를 통한 제조 혁신

그런 sLLM의 운영 과정에는 Public Cloud가 아닌 기업 내의 온프레스미로 동작하는 경우가 일반적이다. 기업에 특화된 자체 sLLM을 보안 등의 문제로 인해 Public Cloud에서 운영할 수는 없다. 또한, 더욱 빠른 속도로 운영하고 정보 유출 방지를 위해 아예 인터넷 연결이 차단된 공장이나 사업체 내부에서만 운영되도록 구성하기도 한다. 더 나아가 기업이 개인 고객들에게 서비스를 제공하는 과정에도 sLLM이 중요한 역할을 수행한다.

LLM을 사용하는 과정에는 인터넷망을 타고 Cloud에서 제공되는 FM에 연결해 Prompt가 입력되고, 이후 LLM이 구동되어 결과물을 생성한다. 이 과정에서 Prompt가 Cloud로 흘러 들어가 개인의 프라이버시가 침해될 수 있으며 속도 지연 현상도 발생한다. 기업의 온프레스미로 sLLM을 운영할 때도 같은 문제가 발생할 수 있다. 이 문제를 극복하기 위해서는 개인이 사용하는 단말기(엣지 디바이스) 내에 sLLM을 탑재하면 된다. 단, 기기에 sLLM을 탑재할 경우 이 sLLM을 구동하기 위한 최소한의 NPU(AI 모델을 구동하기 위한 칩셋)를 필요로 한다.

일반적인 CPU로는 sLLM을 단말기 내에서 구동되기 어렵기 때문이다. 그런 이유로 sLLM을 운영하기 위한 디바이스 차원의 AI 칩셋에 대한 수요가 커지고 있다. 테슬라 자동차와 옵티머스 휴머노이드 로봇 그리고 아이폰15 프로와 갤럭시 S24, 구글 픽셀8에는 그런 AI 칩셋이 탑재되어 AI가 더 빠르게 작동될 수 있도록 하고 있다. 고성능의 노트북과 컴퓨터에도 이같은 AI 칩셋 탑재가 본격화되고 있다. 이를 위해 퀄컴은 스냅드래곤8 3세대를 개발했고, NVIDIA와 AMD, 인텔 그리고 삼성전자와 애플, 구글 역시 그런 AI 칩셋을 본격적으로 개발하고 있다.

이같은 AI 칩셋이 탑재된 엣지 디바이스를 가리켜 On-Device AI라고 부른다. 삼성전자가 1월 말 발표한 갤럭시 S24와 차세대 TV에는 그런 AI 칩셋이 탑재되어 단말기 내에서 번역, 통역, 자막 처리 등의 기능을 수행할 수 있다. 갤럭시 S24로 통화하는 과정에 외국인과 서로 다른 언어로 대화하더라도 폰 내 탑재된 sLLM이 이를 실시간 통역해 준다. 이때 인터넷에 연결되어 Cloud로 데이터를 송수신하는 과정 없이 폰 내에서 작동되므로 속도가 빠를 뿐 아니라 프라이버시 이슈도 해결해 준다.

퀄컴의 스냅드래곤8 3세대 AI 칩셋이 장착된 갤럭시S24

퀄컴의 스냅드래곤8 3세대 AI 칩셋이 장착된 갤럭시S24

NVIDIA는 하이브리드 AI라는 새로운 개념을 소개해 Cloud의 LLM과 (GPU) 컴퓨터나 노트북 내의 sLLM(AI Chipset, RTX 40 Super Series GPU)이 상호작용하면서 속도와 보안 문제를 해결하며 생성형 AI 서비스를 운영할 수 있도록 한다. 일례로 게티이미지라는 수천만 컷의 고품질 일러스트와 사진 등의 이미지를 제공하는 기업이 NVIDIA의 GPU 기반의 LLM을 통해 이미지 생성 서비스를 제공할 경우, 사용자의 컴퓨터에 NVIDIA의 RTX가 탑재되어 있다면 보다 빠른 속도로 AI 이미지 생성 결과물을 확인할 수 있다. 또한, 트위치 등의 방송을 하는 라이브 스트리머가 더 고화질의 영상을 여러 채널에 브로드캐스팅을 할 때에도 컴퓨터에 설치된 RTX를 이용해 AI가 더욱 선명한 해상도로 영상을 생성, 보정해서 전송할 수 있도록 해줄 수 있다.

NVIDIA의 AI GPU를 탑재한 노트북

NVIDIA의 AI GPU를 탑재한 노트북

그렇게 ChatGPT로 시작된 AI는 우리가 사용하는 수많은 기기들로 스며들어 가고 있다. 그렇게 출시된 것이 아이폰 디자이너가 창업한 Humane(샘 알트만이 투자한 회사)의 AI pin으로 옷깃에 부착하는 웨어러블 디바이스로 독자적인 OS에 ChatGPT가 구동되어 작동된다. ChatGPT를 위한, ChatGPT에 의한, ChatGPT의 전용 AI 디바이스인 셈이다. CES 2024에서는 rabbit이라는 스타트업에서 R1이라는 AI 디바이스를 출품해 LAM(Large Action Model)이라는 새로운 방식의 AI를 활용해 Cloud와 연동해서 에이전트가 음성으로 사람의 명령을 인식해서 결괏값을 화면에 출력하는 방식이다.

Humane의 AI pin

Humane의 AI pin

Rabbit의 R1

Rabbit의 R1

AI 기반의 엣지 컴퓨팅이 만들 새로운 세상

사실 가장 기대되는 AI 칩셋을 탑재해 작동될 엣지 디바이스는 MR이다. 메타버스 세상을 열어줄 MR이야말로 새로운 사용자 인터페이스가 필요하고 그러한 역할로서 AI Agent는 핵심적이다. 즉, ChatGPT와 같은 Agent가 MR에 기본 탑재되어 동작하는 것이다. 당연히 그런 Agent가 더 빠르고 안전하게 작동되려면 MR에 AI chip이 탑재되고, 이 Agent의 구동을 위한 sLLM이 내장되면 보다 쾌적한 AI 서비스를 메타버스에서 운영할 수 있을 것이다.

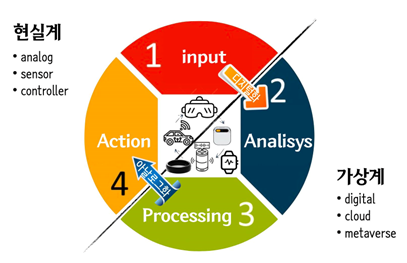

지난 30년간의 컴퓨터 기술은 현실계의 수많은 정보들을 디지털화해서 인터넷계로 옮겨오는 일을 해왔다. 현실과 똑같은 것들이 가상계 속으로 옮겨진 것이다. 책, 뉴스, 만화, 음악, 영상 그리고 우리 현실의 지도와 사고파는 상품들이 그렇게 가상계 속으로 왔다. 은행 계좌도 보험 정보도 심지어 우리의 바이오리듬과 수면 패턴 등 수많은 정보가 가상계로 디지털화되어 들어왔다.

- 현실계

- analog

- sensor

- controller

1.input > 디지털화 > 2. Analisysm, 3 Processing > 아날로그화, 4. Action

- 가상계

- digital

- cloud

- metaverse

이제 앞으로는 디지털 데이터로 축적된 정보들이 MR을 통해 현실 공간에 투영되는 아날로그화가 본격화될 것이다. 가상계에 존재하는 디지털 데이터가 인터넷에만 있는 것이 아니라 현실 공간과 사물과 밀 결합되어 새로운 사용자 경험을 제공할 것이다. 그 과정에서 현실에 존재하는 여러 전자기기들과 로봇에 최소한의 AI가 탑재되어 가상계의 AI와 상호 작용하며 지금껏 우리가 경험하지 못한 현실과 가상이 융합된 새로운 하이브리드 세상을 가능하게 할 것이다.

그때 컴퓨터, 스마트폰, 태블릿을 넘어 TV, 청소기, 냉장고 등의 가전기기와 자동차와 산업용, 가정용 로봇 그리고 새로운 정보 단말기 등은 AI가 기본 탑재될 것이다. 이런 AI가 잘 작동하기 위해 컴퓨터 수준까진 아니어도 AI가 잘 작동될 수 있는 AI Chip은 필수적으로 될 것이다. 그렇게 AI를 품은 엣지 컴퓨팅은 더 많은 기기들의 필수적인 기술이 되어갈 것이다.

▶ 해당 콘텐츠는 저작권법에 의하여 보호받는 저작물로 기고자에게 저작권이 있습니다.

▶ 해당 콘텐츠는 사전 동의 없이 2차 가공 및 영리적인 이용을 금하고 있습니다.

![]()

김지현 | 테크라이터

기술이 우리 일상과 사회에 어떤 변화를 만들고, 기업의 BM 혁신에 어떻게 활용할 수 있을지에 대한 관심과 연구를 하고 있습니다.