과거에는 사용자가 서비스를 사용할 때 주로 마주하게 되는 것이 화면이었습니다. 그렇다면 챗봇이 도입된 서비스는 어떨까요? 이제 사용자들은 서비스의 화면뿐 아니라 챗봇과 대면하기 시작했습니다. 따라서 이전의 화면 기획 단계에서 정의했던 화면의 색감이나 스타일, 용어의 문체, 인터랙션 등이 모두 챗봇을 통해 경험하는 것으로 바뀌었습니다. 그렇다면 이 모든 것을 전달하는 챗봇에도 일관된 컨셉이 필요하지 않을까요? 챗봇의 일관된 컨셉은 챗봇이 어떤 성별, 나이, 성격을 갖고 있는지를 설정함으로써 표현될 수 있습니다. 우리는 이것을 퍼소나(Persona)라고 부릅니다. 이전에는 주로 제품이나 서비스를 기획할 때 해당 서비스를 사용하는 가상의 사용자, 퍼소나를 설정하고 이 사용자의 서비스 경험이 최적화될 수 있도록 기획하였습니다. 하지만 이제 챗봇과 대면해야 하는 상황에서는 사용자 퍼소나뿐 아니라 챗봇의 퍼소나도 고려되어야 합니다.

챗봇의 퍼소나는 왜 중요할까?

사람들은 다른 사람의 목소리를 들을 때, 상대방에 대한 캐릭터(나이, 교육 정도 등)를 자동적으로 머릿속에 형성한다고 합니다.[1] 챗봇 또한 목소리와 같이 자연어로 커뮤니케이션을 하는 대상이라는 점에서 대화를 나누는 순간 사람들이 무의식 중에 캐릭터를 떠올릴 것입니다. 이때 어떤 캐릭터를 떠올리게 만들 것인지 퍼소나를 설정하여 그에 맞는 프로필 사진, 이름, 대화 등을 설계함으로써 의도할 수 있을 것입니다.

챗봇의 퍼소나는 이전에 정의되었던 사용자의 퍼소나와 그 속성이 비슷합니다. 앞서 언급한 것처럼 기본적인 속성으로는 성별, 나이가 있고, 더 나아가서는 성격도 포함됩니다. 기존의 사용자 퍼소나와 다른 점도 있는데, 꼭 사람이 아니어도 된다는 것입니다. 사용자에게 챗봇을 사람인 것처럼 소개할 수도 있고 아예 사람이 아닌 기계, 로봇으로 소개할 수도 있습니다. 이에 따라 성별도 중성으로 설정할 수 있습니다.

이런 퍼소나를 어떻게 설정하느냐에 따라 사람의 행동이 달라진다는 연구 결과들이 있습니다. 같은 내용을 전달하더라도 봇의 퍼소나에 따라 사람의 협조 정도가 달라지고, 이에 따라 행동이 변화하기도 한다는 것입니다.[2] 이에 대한 예시로 가상 환경 내에서 에너지 절약을 요청하는 실험도 있었습니다. 에너지 절약을 요청하는 문구는 같으나, 요청자가 빌딩 그 자체일 때도 있고, 빌딩관리자인 사람일 때도 있었습니다. 또한 빌딩관리자인 경우에는 남자일 때도 있고 여자일 때도 있었습니다. 이 실험에서 참가자들은 요청자가 사람일 때, 그리고 여자일 때, 더 적극적으로 에너지 절약을 실천하는 행동을 취했습니다.[3] 이처럼 대화를 나누는 상대의 퍼소나는 사람의 행동에까지 영향을 미치기에 봇의 퍼소나를 어떻게 설계할 것인지 고민이 필요합니다.

왜 챗봇은 여자가 많을까?

조금 범위를 넓혀보겠습니다. 사람과 대화를 통해 인터랙션하는 것은 챗봇뿐 아니라 보이스봇도 마찬가지인데, 현재 시장에 출시된 보이스봇인 Alexa (Amazon), Cortana (Microsoft), Siri (Apple)는 모두 여성의 이름과 목소리를 갖고 있습니다. 왜 그럴까요? 봇의 성별에 따른 실험 결과를 살펴보면 참가자들은 컴퓨터와 관련한 것은 남성이 더 잘 알 거라고 생각하고, 사람 사이의 관계에 관련된 것은 여성이 더 적합하다고 생각했습니다.[4] 사람들의 고정된 성 관념이 봇의 퍼소나에도 반영된 모습을 볼 수 있습니다. 이러한 현실은 여성이 순종적이고 부차적인 역할에 적합하다는 편향된 이미지를 심어줄 수 있어 주의를 요해야 한다고 합니다.[5] 또한 최근 이슈가 된 AI 챗봇 ‘이루다’의 경우, 챗봇 퍼소나를 20대 여성으로 택했는데 성적 도구화, 성희롱 등이 문제가 되기도 했습니다.[6]

Solution ① 챗봇이 꼭 여성일 필요는 없어요!

모든 사람들이 언제나 여성 챗봇을 선호할까요? 실제로 그러한지 연구 결과를 살펴보겠습니다.

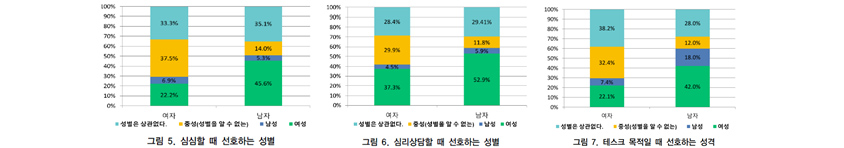

- 여자 - 성별상관없다:33.3%, 중성(성별을 알수 없는):37.5%,남성:6.9%,여성:22.2%

- 남자 - 성별상관없다:35.1%, 중성(성별을 알수 없는):14.0%,남성:5.3%,여성:45.6%

- 여자 - 성별상관없다:28.4%, 중성(성별을 알수 없는):29.9%,남성:4.5%,여성:37.3%

- 남자 - 성별상관없다:29.41%, 중성(성별을 알수 없는):11.8%,남성:5.9%,여성:52.9%

- 여자 - 성별상관없다:38.2%, 중성(성별을 알수 없는):32.4%,남성:7.4%,여성:22.1%

- 남자 - 성별상관없다:28.0%, 중성(성별을 알수 없는):12.0%,남성:18.0%,여성:42.0%

연구 결과를 살펴보면 크게 사용 목적을 심심할 때 시간 때우기, 심리 상담할 때, 태스크 처리로 구분했을 때 여성의 경우 심리 상담할 때를 제외하고는 성별에 대한 선호가 없었고, 남성은 사용 목적에 상관없이 모두 여성의 챗봇을 선호한다는 재미있는 결과가 있었습니다. 또한 남여 모두 사용 목적에 상관없이 40% 이상은 성별이 상관없거나, 중성을 선호한다고 대답했습니다.

챗봇이 확산됨에 따라 그 사용 목적은 매우 다양해질 것입니다. 그리고 챗봇 사용자도 그룹마다 제각기 가진 성향과 특색이 다를 것입니다. 만약 심리 상담을 목적으로 하는 챗봇이 아니라면, 여성 외의 성별도 고려해 보기 바랍니다. 많은 사람들이 성별에 선호가 없거나 오히려 중성을 선호하고 있고, 성별을 특정했을 때에는 예상치 못한 문제들이 많이 야기될 수 있기 때문입니다.

Solution ② 사용 목적에 따라 챗봇의 나이를 정해주세요!

나이는 어떨까요? 심심할 때 시간 때우기나 심리상담을 목적으로 한 챗봇의 경우에는 설문 응답자의 나이에 따라 선호하는 연령대가 달랐습니다. 보통 심심할 때는 본인 또래나 나이가 더 어린 챗봇, 심리상담은 또래나 나이가 더 많은 연령대를 선호했습니다. 이에 비해 태스크 목적의 챗봇으로는 응답자의 나이와 상관없이 모두가 고르게 30대를 선호하는 것으로 나타났습니다. 30대가 사회생활을 가장 왕성하게 일을 하고 있는 연령대로 일을 처리해 준다는 관점에서 가장 선호되고 있는 것으로 해석됩니다.[8] 이러한 연구 결과를 볼 때, 문제 해결을 위한 챗봇으로 가장 많이 활용되는 고객센터의 챗봇으로는 30대를 퍼소나로 설정하는 것이 고르게 여러 연령대의 호감을 사는 데 유리해 보입니다.

Solution ③ 사용자에게 챗봇 퍼소나를 선택할 수 있게 하세요!

챗봇을 정해진 성별, 나이로만 제공하지 말고 사용자가 선호하는 퍼소나의 챗봇을 선택할 수 있도록 하면 어떨까요? 사용자의 성별, 나이에 따라 선호하는 퍼소나가 달라질 수 있으니 선택권을 넓히는 것도 하나의 방법입니다.

현대카드 챗봇 버디 (2017년)[9]

현대카드 챗봇 버디 (2017년)[9]

실제로 2017년 IBM 왓슨 어시스턴트(IBM Watson Assistant)를 도입한 현대카드 챗봇은 상담원의 퍼소나를 2가지로 설정하고, 사용자가 선택할 수 있도록 했습니다. Fiona라는 이름의 챗봇은 친구처럼 수다를 떨어주는 말투로 퍼소나가 설정되어 있고, Henry는 예의 있는 말투로 퍼소나가 설정되어 있습니다. 이 사례는 사용자가 각자의 취향에 맞는 챗봇을 선택할 수 있었던 좋은 시도라고 보여집니다.

어떤 성격이 사람과의 상호작용에 도움을 줄까?

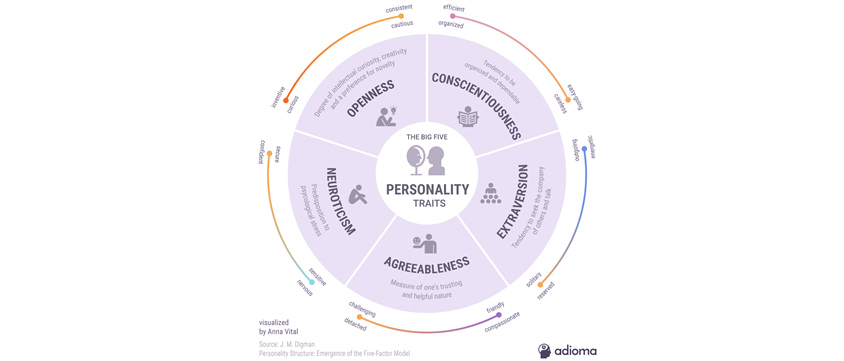

성별, 나이와 같은 인구통계학적 요인 외에 챗봇의 성격(Personality)도 사람에게 영향을 미칩니다. 챗봇의 성격은 Five Factor Model(FFM, 혹은 Big Five Personality Traits)에 기반하여 설계하는 경우가 많습니다.

- visualized by Anna Vital - Openness, Neuroticism

- adioma - Conscientiousness, Extraversion

- Agreeableness

FFM은 인간의 성격이 개방성(Openness), 성실성(Conscientiousness), 외향성(Extraversion), 친화성(Agreeableness), 신경성(Neuroticism)의 5가지 특질로 결정된다는 이론으로,[11] 근래의 심리학계에서 널리 받아들여지고 있습니다. 이 5가지 특질을 바탕으로 챗봇의 성격을 설계할 때, 각 특질에 얼마나 높은 점수를 줄 것인지 고려해야 합니다. 그리고 그 5가지 각 점수의 조합이 챗봇의 성격이 되는 것입니다.

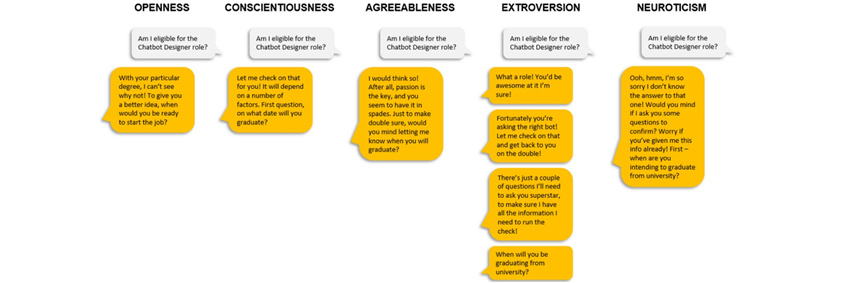

- Openness

- Am I eligble for the Chatbot Designer role?

- with your degree, I can't ee why not To give you a better idea, when would you be ready to that the job?

- Conscientiousness

- Am I eligble for the Chatbot Designer role?

- Let me check on that for you! It will depend on a number of faction. First Question, on what will you graduate?

- Agreeableness

- Am I eligble for the Chatbot Designer role?

- I would think so! After all,passion is thw key, and you seem to here it in spedes. when you will graduate?

- Extraversion

- Am I eligble for the Chatbot Designer role?

- what a role! you'd be WESOME at it I'm sure!

- Neuroticism

- Am I eligble for the Chatbot Designer role?

- Ooh, hmm, I'm so sorry I don't know the answer to that one! Would you mind if i ask you some questions to confirm?

그림을 보면 실제로 각 특질에 높은 점수를 얻은 챗봇이 같은 질문에 대해서도 각기 다른 대답을 내놓도록 설계된 것을 볼 수 있습니다. 외향성이 높은 챗봇은 우선 대답이 굉장히 길고, 여러 번 끊어서 전달하고 성실성이 높은 챗봇은 비교적 객관적이고 차분하게 대답을 이어간다는 걸 확인 할 수 있습니다. 그리고 이렇게 FFM을 바탕으로 성격이 잘 설계된 챗봇은 사용자 경험을 개선하고, 더 매력적으로 느껴진다고 합니다.[13] 이제부터는 구체적으로 어떤 챗봇의 성격에 사람들이 높은 점수를 주는지, 호감을 이끌어 내는지 확인해보겠습니다.

Solution ① 긍정적인 말투가 중요해요!

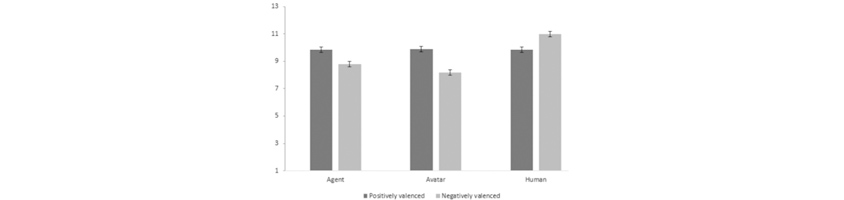

먼저 챗봇과 같이 대화를 통해 인터랙션하는 보이스봇 연구 결과를 살펴볼까요? Gale M. Lucas는 연구를 통해 보이스봇의 긍정적인 말투는 실제 사람의 말투보다 더 큰 영향을 준다는 것을 밝혀냈습니다. 헬스 트레이너와 스카이프(Skype)를 통해 소통하며 운동을 하게 하는 실험이었는데, 긍정적인 말투의 스크립트와 부정적인 스크립트를 미리 녹음한 후에, 참가자 중 일부는 실제 사람이 말하고 있다고 믿게 하고, 일부는 AI가 운영하는 보이스봇이 말하고 있다고 믿게 하였습니다.

- Agent - Postively valenced :10, Negatively valenced :9

- Avatar - Postively valenced :10, Negatively valenced :8

- Human - Postively valenced :10, Negatively valenced :11

같은 스크립트의 내용을 말했지만, 운동이 끝난 후 실제 사람이 말하는 것으로 믿었던 참가자들은 부정적인 말투의 사람이 더 좋은 트레이너라고 평가한 반면, AI라고 믿었던 사람들은 긍정적인 말투의 에이전트에게 더 좋은 점수를 주었습니다. 심지어 심박수 측정을 통한 객관적 운동 효과는 부정적인 말투일 때에 더 효과적이었음에도 AI라고 믿었던 사람들은 긍정적인 말투에 점수를 더 좋게 준 것입니다. Ewa Luger의 실험에서도 사람들은 긍정적인 태도와 분위기의 보이스봇(Siri, Alexa등)를 선호한다고 밝혀졌습니다. [15] 보이스봇의 성격에 대한 연구 결과를 토대로 챗봇 또한 긍정적인 말투로 사용자를 대할 때 더 좋은 평가를 받으며, 이러한 말투가 실제 사람일 때 보다 더 큰 영향을 미친다고 생각해 볼 수 있습니다.

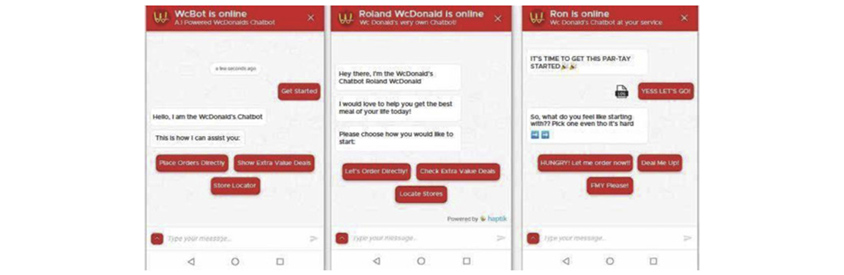

Solution ② 친근한 챗봇이 사용자의 마음을 열어요!

10대에서 50대까지 다양한 연령대의 참가자를 대상으로 한 연구가 있었습니다. Brinda Mehra는 앞서 언급한 사람 성격을 결정하는 5가지 특질에 대한 이론인 FFM(Five Factor Model)을 기반으로 업무적인(transactional), 사회적인(prosocial), 친근한(friendly) 성격의 챗봇을 각각 설계한 후 참가자들에게 음식을 주문하도록 했습니다.

왼쪽부터 업무적인, 사회적인, 친근한 성격으로 설계된 챗봇[16]

왼쪽부터 업무적인, 사회적인, 친근한 성격으로 설계된 챗봇[16]

그림에서처럼 챗봇이 먼저 자신을 소개하고, 주문을 받고 주문을 확인한 후 종료하는 여정을 경험하도록 했고, 설계된 성격에 따라 같은 질문이라도 서로 다른 대답을 하도록 했습니다. 참가자들은 대화를 마친 후에 다시 사용할 가능성, 편안함, 생산 및 효율성 항목에 대해 점수를 주었습니다. 그리고 그 결과 친근한 챗봇이 3가지 분야 모두에서 가장 높은 점수를 얻었습니다. 이 실험을 통해 사용자에게 친근한 챗봇은 연령대에 상관없이 대부분의 사람에게 편안하게 다가가며, 다시 사용할 가능성을 높여준다는 것을 알 수 있습니다.

우리의 제언

지금까지 챗봇에 있어 퍼소나가 얼마나 중요하고, 어떻게 사용자에게 영향을 미치는지 알아보았습니다. 기본적으로 챗봇은 사람들 모두가 선호하는 긍정적이면서 친근한 성격을 바탕으로 사용자의 성별, 나이 그리고 사용 목적에 따라 적합한 퍼소나를 설정해야 합니다. 실제로 설정된 퍼소나에 따라 사용자가 조금 더 적극적으로 챗봇의 요구에 응할 수도 있고, 더 호감을 갖게 될 수도 있기에 매우 중요합니다. 그리고 챗봇을 만들다 보면 앞에서 얘기한 것 외에도 고려해야 할 것들이 훨씬 더 많을 것입니다. 이러한 부분은 챗봇의 사용 목적과 사용하게 될 사용자에 대해 철저한 분석을 선행한 후에 그에 적합하게 설계하며 채워나가야 할 것입니다. 특히 여전히 논란이 되고 있는 챗봇은 사람다워야 하는지, 사람다워야 한다면 어떻게 사람처럼 느껴지게 할지 다음 편에 자세하게 얘기해 보겠습니다.

References

[1] Shiffrin, R.M., Schneider, W., 1977. Controlled and automatic human information processing: II. Perceptual learning, automatic attending and a general theory.

Psychological Review 84, 127–190.

https://doi.org/10.1037/0033-295X.84.2.127

[2] Nowak, K.L., Watt, J., Walther, J.B., 2009. Computer mediated teamwork and the efficiency framework: Exploring the influence of synchrony and cues on media satisfaction and outcome success. Computers in Human Behavior, Including the Special Issue: Design Patterns for Augmenting E-Learning Experiences 25, 1108–1119.

https://doi.org/10.1016/j.chb.2009.05.006

[3] Khashe, S., Lucas, G., Becerik-Gerber, B., Gratch, J., 2017. Buildings with persona: Towards effective building-occupant communication. Computers in Human Behavior 75, 607–618.

https://doi.org/10.1016/j.chb.2017.05.040

[4] Nass, C., Moon, Y., Green, N., 1997. Are Machines Gender Neutral? Gender-Stereotypic Responses to Computers With Voices. Journal of Applied Social Psychology 27, 864–876.

https://doi.org/10.1111/j.1559-1816.1997.tb00275.x

[5] Loideain, N.N., Adams, R., 2020. From Alexa to Siri and the GDPR: The gendering of Virtual Personal Assistants and the role of Data Protection Impact Assessments. Computer Law & Security Review 36, 105366.

https://doi.org/10.1016/j.clsr.2019.105366

[6] 출시 일주일 만에…’20살 AI 여성’ 성희롱이 시작됐다 | 연합뉴스 [WWW Document], n.d. URL https://www.yna.co.kr/view/AKR20210107153300017 (accessed 4.21.21).

[7] KangMinjeong, 2018. 사용목적에 따라 선호하는 챗봇의 성격에 관한 연구. 한국콘텐츠학회논문지 18, 319–329.

https://doi.org/10.5392/JKCA.2018.18.05.319

[8] KangMinjeong, 2018. 사용목적에 따라 선호하는 챗봇의 성격에 관한 연구. 한국콘텐츠학회논문지 18, 319–329.

https://doi.org/10.5392/JKCA.2018.18.05.319

[9] Hyundai card x our own night - 그래픽 디자인, 일러스트레이션 [WWW Document], n.d. URL https://notefolio.net/our_own_night/83378 (accessed 4.21.21).

[10] Vital, A., 2018. 5 Personality Traits - Infographic. Adioma. URL https://blog.adioma.com/5-personality-traits-infographic/ (accessed 5.3.21).

[11] John, O., Naumann, L., Soto, C., 2008. Paradigm shift to the integrative big five trait taxonomy: History, measurement, and conceptual issues, in: Handbook of Personality: Theory and Research, 3 Edn. pp. 114–158.

[12] Katz, S., 2020. The ultimate guide to chatbot personality [WWW Document]. Medium. URL https://chatbotsmagazine.com/the-ultimate-guide-to-chatbot-personality-b9665ab5e99d (accessed 5.3.21).

[13] Smestad, T.L., Volden, F., 2018. Chatbot Personalities Matters - Improving the User Experience of Chatbot Interfaces, in: INSCI Workshops.

[14] Lucas, G.M., Krämer, N., Peters, C., Taesch, L.-S., Mell, J., Gratch, J., 2018. Effects of Perceived Agency and Message Tone in Responding to a Virtual Personal Trainer, in: Proceedings of the 18th International Conference on Intelligent Virtual Agents, IVA ’18. Association for Computing Machinery, New York, NY, USA, pp. 247–254.

https://doi.org/10.1145/3267851.3267855

[15] Luger, E., Sellen, A., 2016. “Like Having a Really Bad PA”: The Gulf between User Expectation and Experience of Conversational Agents, in: Proceedings of the 2016 CHI Conference on Human Factors in Computing Systems, CHI ’16. Association for Computing Machinery, New York, NY, USA, pp. 5286–5297.

https://doi.org/10.1145/2858036.2858288

[16] Mehra, B., 2021. Chatbot personality preferences in Global South urban English speakers. Social Sciences & Humanities Open 3, 100131.

https://doi.org/10.1016/j.ssaho.2021.100131

▶ 해당 콘텐츠는 저작권법에 의하여 보호받는 저작물로 기고자에게 저작권이 있습니다.

▶ 해당 콘텐츠는 사전 동의 없이 2차 가공 및 영리적인 이용을 금하고 있습니다.

![]()

Digital Transformation 환경에서 고객 가치를 혁신하는 CX 전략을 제안하고 사용자의 컨텍스트에 기반한 최적의 고객 경험을 설계합니다.